DeepSeek是最近人工智能领域备受瞩目的一个语言模型系列,其在不同版本的发布过程中,逐步加强了对多种任务的处理能力。本文将详细介绍DeepSeek的各版本,从版本的发布时间、特点、优势以及不足之处,为广大AI技术爱好者和开发者提供一份参考指南。

1、DeepSeek-V1:起步与编码强劲

DeepSeek-V1是DeepSeek的起步版本,这里不过多赘述,主要分析它的优缺点。

发布时间:

2024年1月

特点:

DeepSeek-V1是DeepSeek系列的首个版本,预训练于2TB的标记数据,主打自然语言处理和编码任务。它支持多种编程语言,具有强大的编码能力,适合程序开发人员和技术研究人员使用。

优势:

- 强大编码能力:支持多种编程语言,能够理解和生成代码,适合开发者进行自动化代码生成与调试。

- 高上下文窗口:支持高达128K标记的上下文窗口,能够处理较为复杂的文本理解和生成任务。

缺点:

- 多模态能力有限:该版本主要集中在文本处理上,缺少对图像、语音等多模态任务的支持。

- 推理能力较弱:尽管在自然语言处理和编码方面表现优异,但在复杂逻辑推理和深层次推理任务中,表现不如后续版本。

2、DeepSeek-V2系列:性能提升与开源生态

作为DeepSeek的早期版本,DeepSeek-V2的性能比DeepSeek-V1提升了太多,其差距和ChatGPT的首个版本和ChatGPT3.5相比一样。

发布时间:

2024年上半年

特点:

DeepSeek-V2系列搭载了2360亿个参数,是一个高效且强大的版本。它具有高性能和低训练成本的特点,支持完全开源和免费商用,极大地促进了AI应用的普及。

优势:

- 高效的性能与低成本:训练成本仅为GPT-4-Turbo的1%,大幅降低了开发门槛,适合科研和商业化应用。

- 开源与免费商用:与前一个版本相比,V2支持完全开源,并且用户可以自由进行商用,这使得DeepSeek的生态更加开放和多样化。

缺点:

- 推理速度较慢:尽管参数量庞大,但在推理速度方面,DeepSeek-V2相较于后续版本依然较慢,影响了实时任务的表现。

- 多模态能力局限:与V1类似,V2版本在处理非文本任务(如图像、音频)时的表现并不出色。

3、DeepSeek-V2.5系列:数学与网络搜索突破

发布时间:

2024年9月

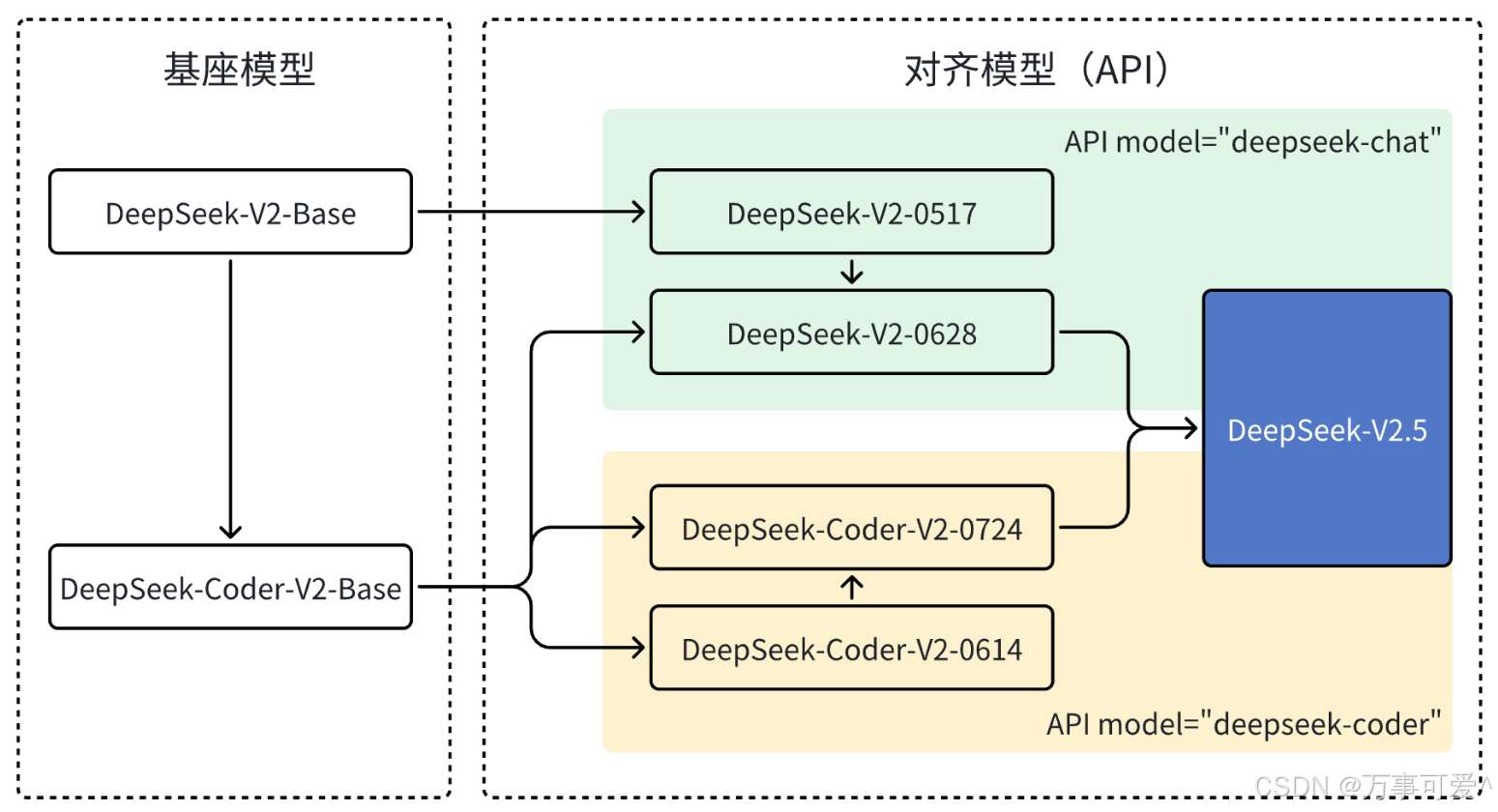

下面是官方对于V2.5版本的更新日志:

DeepSeek 一直专注于模型的改进和优化。在 6 月份,我们对 DeepSeek-V2-Chat 进行了重大升级,用 Coder V2

的 Base 模型替换原有的 Chat 的 Base 模型,显著提升了其代码生成和推理能力,并发布了

DeepSeek-V2-Chat-0628 版本。紧接着,DeepSeek-Coder-V2 在原有 Base

模型的基础上,通过对齐优化,大大提升通用能力后推出了 DeepSeek-Coder-V2 0724 版本。最终,我们成功将 Chat 和

Coder 两个模型合并,推出了全新的DeepSeek-V2.5 版本。

可以看出官方在这次更新中融合了Chat和Coder两个模型,使得DeepSeek-V2.5能够辅助开发者处理更高难度的任务。

- Chat模型:专门为对话系统(聊天机器人)设计和优化,用于生成自然语言对话,能够理解上下文并生成连贯且有意义的回复,常见应用如聊天机器人、智能助手等。

- Coder模型:是一种基于深度学习技术,经过大量代码数据训练,能够理解、生成和处理代码的人工智能模型。

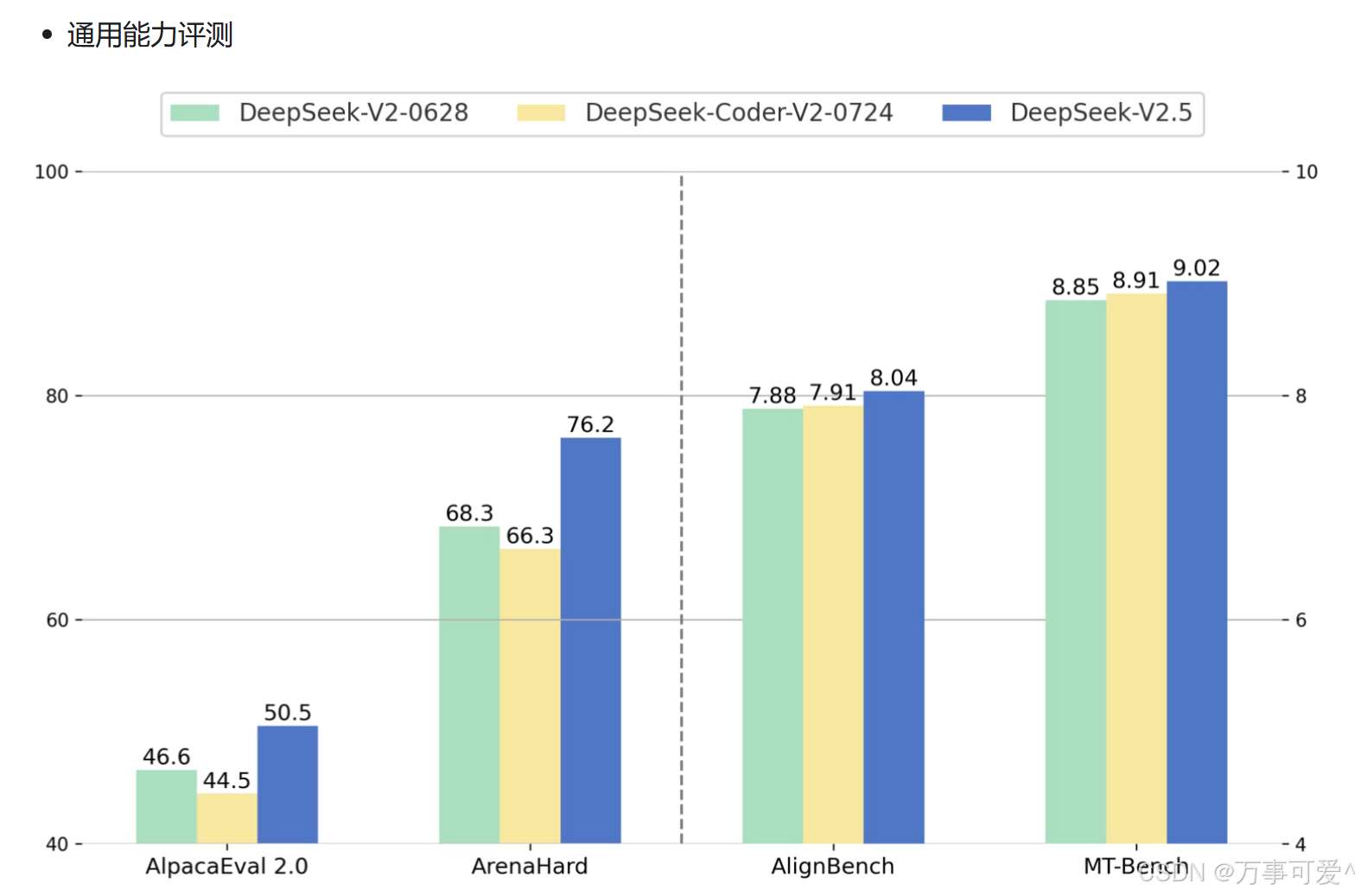

并且从官方发布的数据来看,V2.5在通用能力(创作、问答等)等问题中表现对比V2模型来说,有了显著得提升。

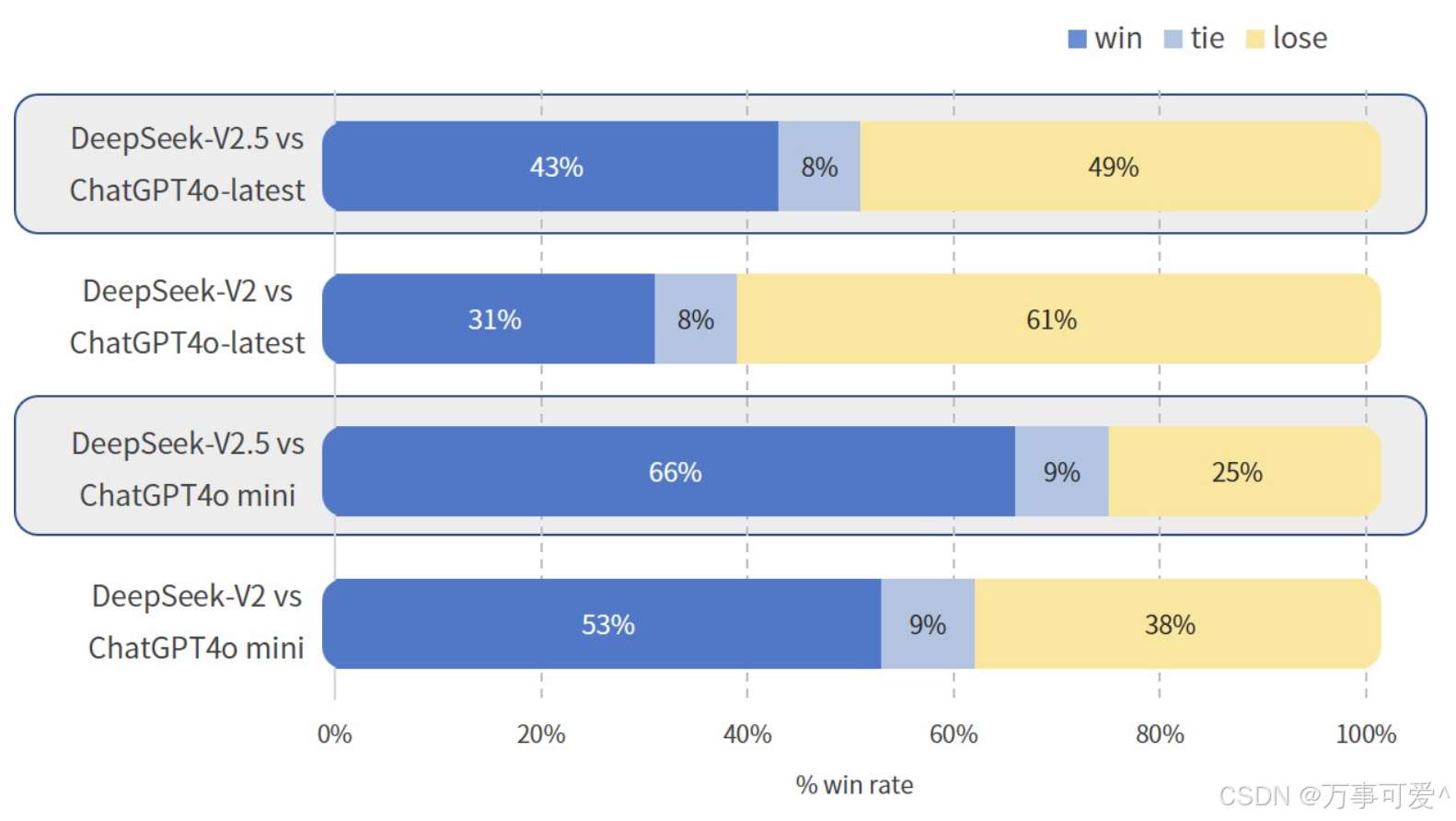

下面用一张图来对比一下DeepSeek - V2 和 DeepSeek - V2.5 两个版本模型分别与 ChatGPT4o - latest 和 ChatGPT4o mini的通用能力对比测试。

在这张图中我们可以看出DeepSeek - V2和DeepSeek - V2.5两个版本模型分别与ChatGPT4o - latest和ChatGPT4o mini进行对比测试的胜率、平局率和败率情况:

- DeepSeek - V2.5 vs ChatGPT4o - latest:DeepSeek - V2.5的胜率为43%,平局率为8%,败率为49% 。

- DeepSeek - V2 vs ChatGPT4o - latest:DeepSeek - V2的胜率为31%,平局率为8%,败率为61% 。

- DeepSeek - V2.5 vs ChatGPT4o mini:DeepSeek - V2.5的胜率为66%,平局率为9%,败率为25% 。

- DeepSeek - V2 vs ChatGPT4o mini:DeepSeek - V2的胜率为53%,平局率为9%,败率为38% 。

在与ChatGPT4o系列模型的对比中,DeepSeek - V2.5整体表现优于DeepSeek - V2;DeepSeek - V2.5和DeepSeek - V2在与ChatGPT4o mini的对比中胜率相对较高,而与ChatGPT4o - latest对比时胜率相对较低。

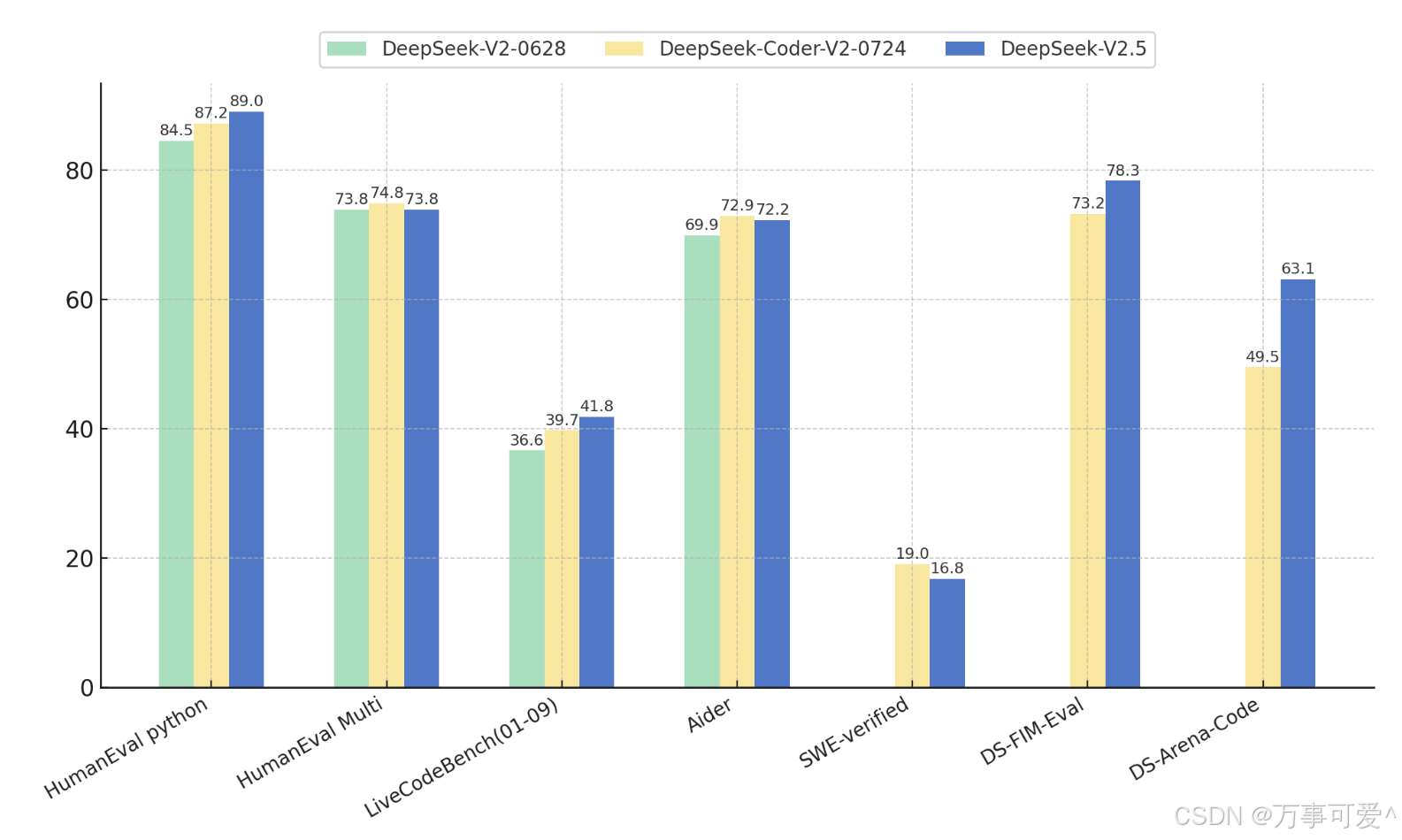

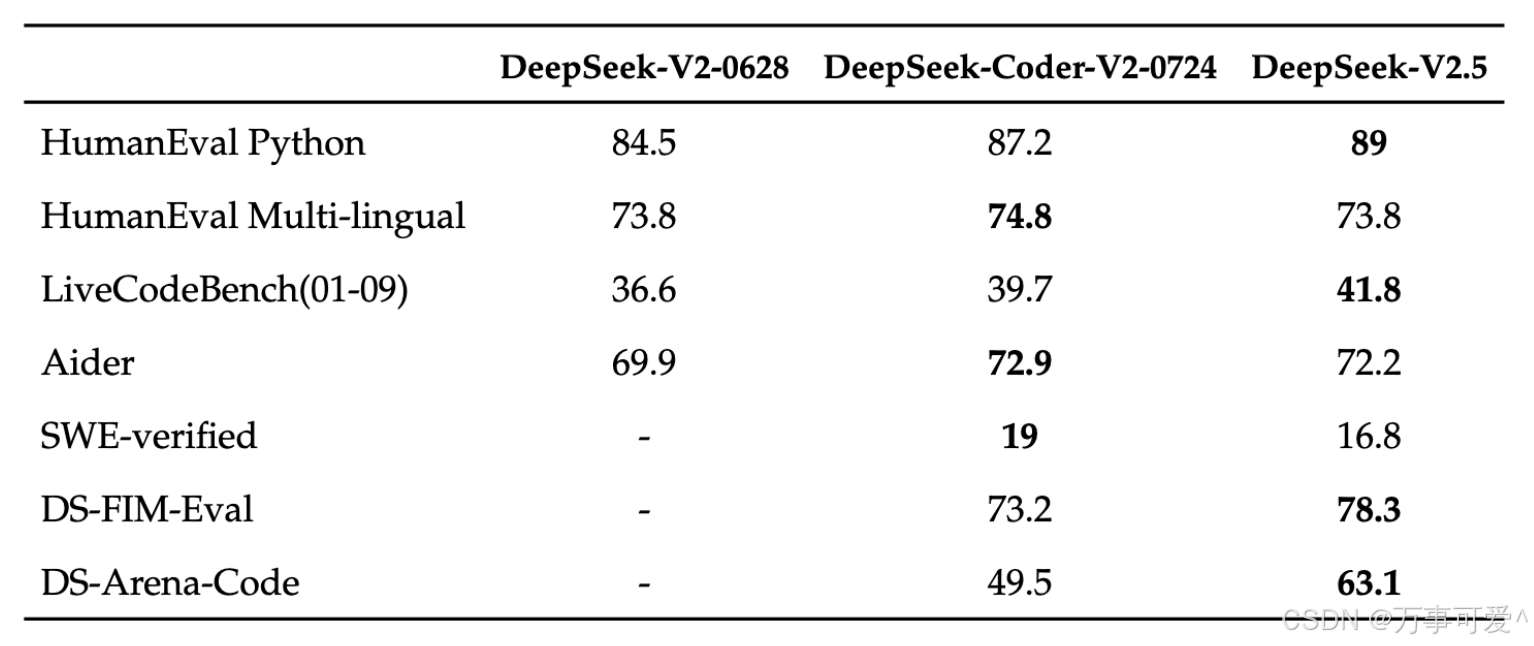

在代码方面,DeepSeek-V2.5 保留了 DeepSeek-Coder-V2-0724 强大的代码能力。在 HumanEval

Python 和LiveCodeBench(2024 年 1 月 - 2024 年 9 月)测试中,DeepSeek-V2.5

显示了较为显著的改进。在 HumanEval Multilingual 和 Aider 测试中,DeepSeek-Coder-V2-0724

略胜一筹。在 SWE-verified

测试中,两个版本的表现都较低,表明在此方面仍需进一步优化。另外,在FIM补全任务上,内部评测集DS-FIM-Eval的评分提升了

5.1%,可以带来更好的插件补全体验。

另外,DeepSeek-V2.5对代码常见场景进行了优化,以提升实际使用的表现。在内部的主观评测 DS-Arena-Code

中,DeepSeek-V2.5 对战竞品的胜率(GPT-4o 为裁判)取得了显著提升。

特点:

DeepSeek-V2.5在前一个版本的基础上进行了一些关键性改进,尤其是在数学推理和写作领域,表现得更加优异。同时,该版本加入了联网搜索功能,能够实时分析海量网页信息,增强了模型的实时性和数据丰富度。

优势:

- 数学和写作能力提升:在复杂的数学问题和创作写作方面,DeepSeek-V2.5表现优异,能够辅助开发者处理更高难度的任务。

- 联网搜索功能:通过联网,模型可以抓取最新的网页信息,对当前互联网资源进行分析和理解,提升模型的实时性和信息广度。

缺点:

- API限制:虽然具备联网搜索能力,但API接口不支持该功能,影响了一些用户的实际应用场景。

- 多模态能力依然有限:尽管在多方面有所改进,但V2.5在多模态任务上仍然存在局限性,无法与专门的多模态模型媲美。

DeepSeek-V2.5 现已开源到了 HuggingFace:https://huggingface.co/deepseek-ai/DeepSeek-V2.5

4、DeepSeek-R1-Lite系列:推理模型预览版上线,解密o1推理过程

发布时间:

2024年11月20日

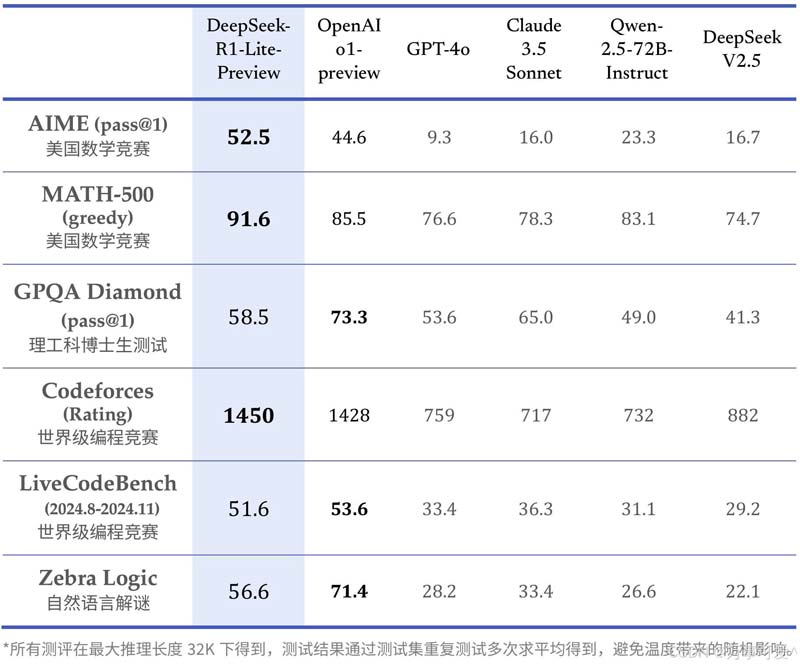

不得不说DeepSeek版本的迭代速度很快,同年11月划历史意义的R1-Lite模型发布。作为R1模型的前置版本,虽然没有R1模型那样备受瞩目,但是其作为对标OpenAI o1的国产推理模型,表现也是可圈可点的,DeepSeek-R1-Lite 预览版模型在美国数学竞赛(AMC)中难度等级最高的 AIME 以及全球顶级编程竞赛(codeforces)等权威评测中,均取得了卓越的成绩,大幅超越了 GPT-4o 等知名模型。

下表为 DeepSeek-R1-Lite 在各项相关评测中的得分结果:

DeepSeek - R1 - Lite - Preview 在数学竞赛(AIME、MATH - 500)和世界级编程竞赛(Codeforces)的测试任务中表现突出,在理工科博士生测试、另一世界级编程竞赛和自然语言解谜任务中也有不错表现,但在理工科博士生测试、自然语言解谜等任务中,OpenAI o1 - preview 得分更优,这也是DeepSeek - R1 - Lite没有得到太多关注的原因 。

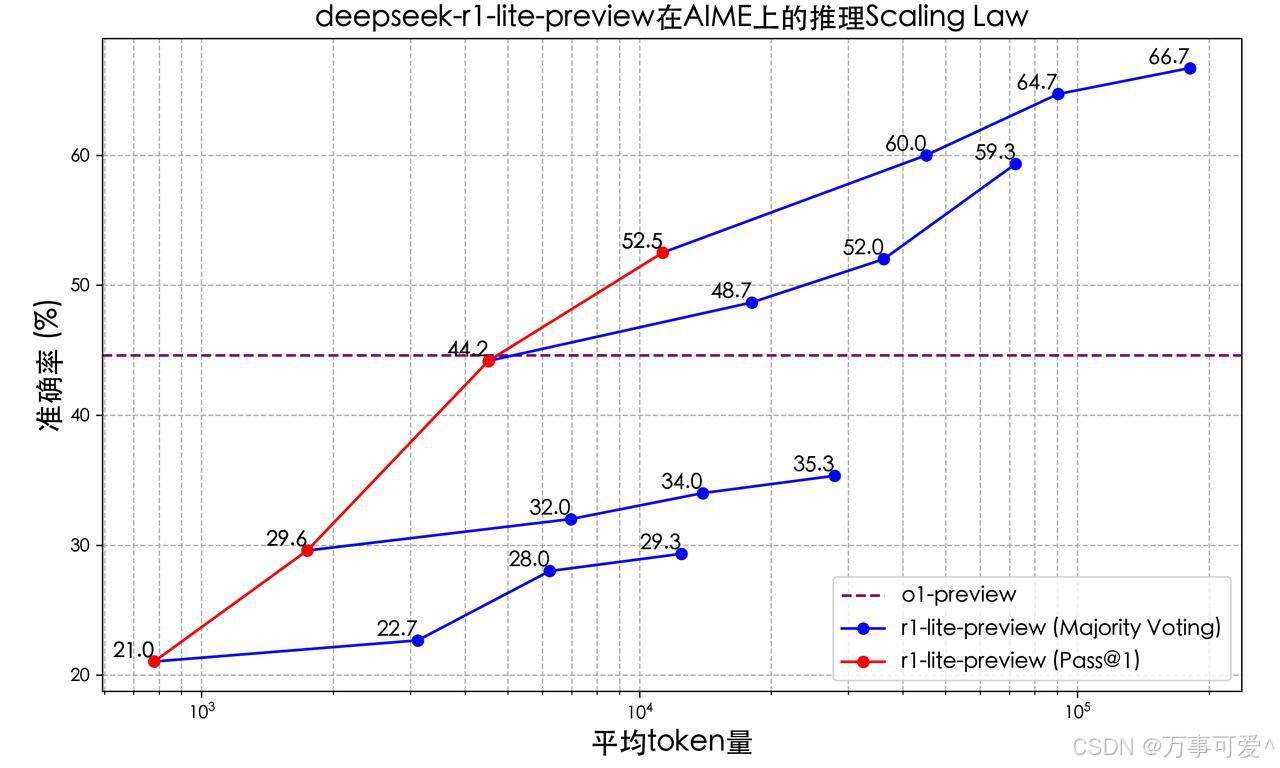

根据官网消息,DeepSeek-R1-Lite 的推理过程长,并且包含了大量的反思和验证。下图展示了模型在数学竞赛上的得分与测试所允许思考的长度紧密相关。

由上图可以看出:

- DeepSeek - R1 - Lite - Preview 的准确率随着平均 token。量的增加而显著提升,在采用多数投票法时,提升效果更为明显,最终超过 OpenAI o1 - preview 的表现。

- 在一次通过(Pass@1)情况下,DeepSeek - R1 - Lite - Preview 在平均 token量达到一定程度时,准确率也高于 OpenAI o1 - preview 的 44.2% 。 特点

使用强化学习训练,推理过程包含大量反思和验证,思维链长度可达数万字,在数学和编程等需要长逻辑链条的任务中具备优势;在数学、代码以及各种复杂逻辑推理任务上,取得了媲美o1的推理效果,并展现了o1未公开的完整思考过程,目前在DeepSeek官网上免费可用。

优点

- 推理能力强:在一些高难度的数学和代码任务中表现优异,在美国数学竞赛(AMC)和全球编程竞赛(codeforces)等测试中,超越了现有的顶级模型,甚至在某些任务上超过了OpenAI的o1 。例如在密码解密测试中,成功破解了一个依赖复杂逻辑的密码,而o1 - preview则未能正确解答。

- 思考过程详细:在答题时不仅提供答案,还会附上详细的思考过程和反向思考的验证过程,显示出逻辑推理的严谨性。

- 性价比高:所属公司DeepSeek产品以开源为主,其模型训练成本远低于行业主流模型,性价比具有显著优势。

缺点

- 代码生成表现不稳定:在生成一些相对简单的代码时表现不如预期。

- 知识引用能力不足:在处理一些需要现代知识引用的复杂测试时,未能达到令人满意的效果。

- 语言交互问题:使用过程中可能出现中英文思考、输出混乱的问题。

5、DeepSeek-V3系列:大规模模型与推理速度提升

发布时间:

2024年12月26日

作为深度求索公司自主研发的首款混合专家(MoE)模型,其拥有6710亿参数,激活370亿,在14.8万亿token上完成了预训练。

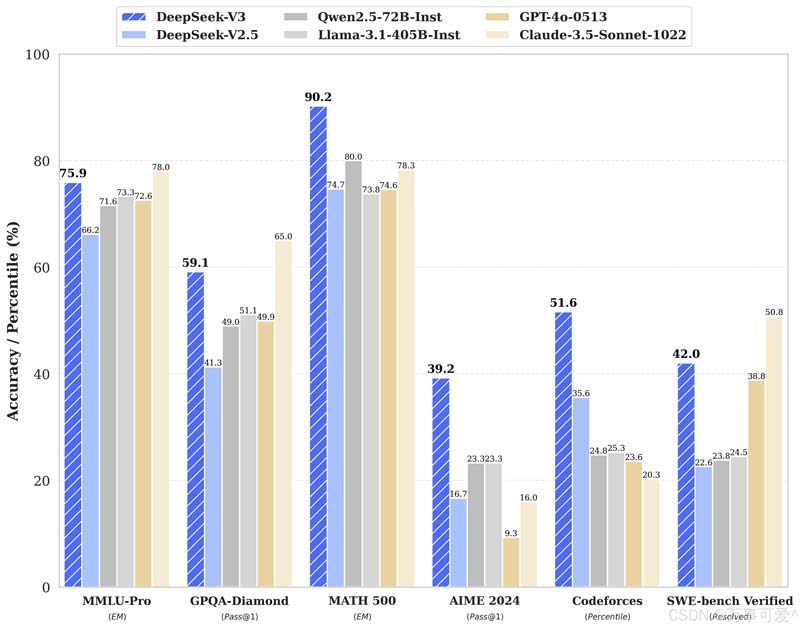

DeepSeek-V3 多项评测成绩超越了 Qwen2.5-72B 和 Llama-3.1-405B 等其他开源模型,并在性能上和世界顶尖的闭源模型 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

DeepSeek - V3 在 MMLU - Pro、MATH 500、Codeforces 任务测试中表现突出,准确率领先;在 GPQA Diamond、SWE - bench Verified 任务中也有不错表现,但在 AIME 2024 任务中,GPT - 4o - 0513 准确率更优。

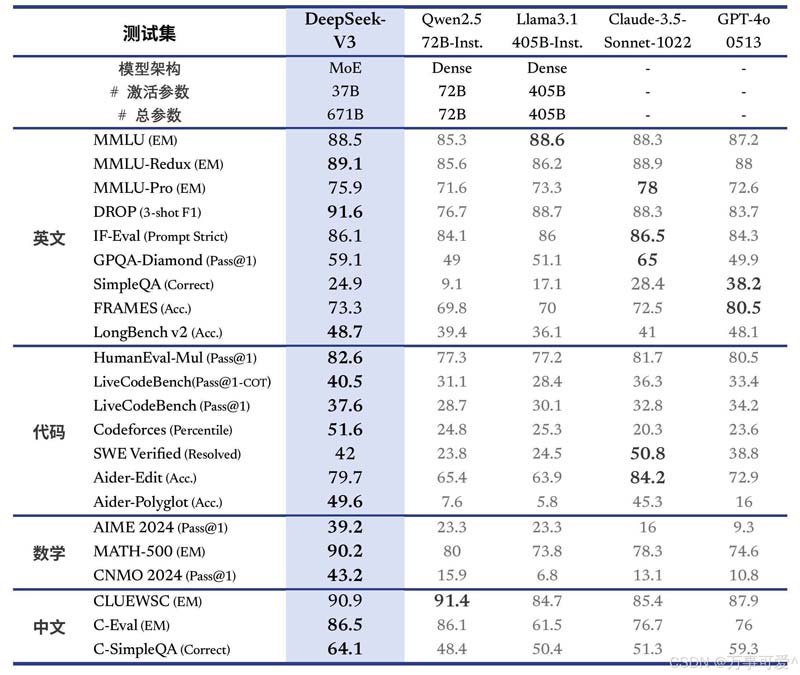

由上面表格可以看出,这项对比涉及DeepSeek - V3、Qwen2.5 - 72B - Inst、Llama3.1 - 405B - Inst、Claude - 3.5 - Sonnet - 1022、GPT - 4o - 0513等模型,从模型架构、参数及各测试集表现等方面分析得出:

模型架构与参数

- DeepSeek - V3:采用MoE架构,激活参数37B,总参数671B。

- Qwen2.5 - 72B - Inst:Dense架构,激活参数72B,总参数72B。

- Llama3.1 - 405B - Inst:Dense架构,激活参数405B,总参数405B。其他两个模型未公开当前信息。

英文测试集表现

- MMLU相关:DeepSeek - V3在MMLU - EM、MMLU - Redux EM、MMLUPro - EM测试中,成绩分别为88.5、89.1、75.9 ,在部分测试中与其他模型表现接近。

- DROP:DeepSeek - V3得分为91.6,领先于其他模型。

- IF - Eval:DeepSeek - V3为86.1,和其他模型成绩相当。

- GPQA - Diamond:DeepSeek - V3得分59.1,仅次于Claude - 3.5 - Sonnet - 1022的65。

- SimpleQA等:在SimpleQA、FRAMES、LongBench v2等测试中,DeepSeek - V3表现有差异,如SimpleQA得分为24.9,FRAMES为73.3 。

代码测试集表现

- HumanEval - Mul:DeepSeek - V3得分为82.6,表现较好。

- LiveCodeBench:在LiveCodeBench (Pass@1 - COT)和LiveCodeBench (Pass@1)测试中,DeepSeek - V3分别为40.5、37.6 。

- Codeforces等:在Codeforces Percentile测试中DeepSeek - V3得分为51.6,在SWE - bench Verified (Resolved)中得分为42 。

数学测试集表现

- AIME 2024:DeepSeek - V3得分为39.2,高于Qwen2.5 - 72B - Inst、Llama3.1 - 405B - Inst、Claude - 3.5 - Sonnet - 1022 。

- MATH - 500:DeepSeek - V3得分为90.2,优势明显。

中文测试集表现

- CLUEWSC:DeepSeek - V3得分为90.9,和其他模型成绩接近。

- C - Eval等:在C - Eval、C - SimpleQA测试中,DeepSeek - V3分别为86.5、64.1 。

总体来看,DeepSeek - V3在多个测试集上有不错表现,在DROP、MATH - 500等测试中优势明显,在不同语言和领域的测试集中各模型有不同程度的优势与不足。

特点:

DeepSeek-V3是该系列中的一个里程碑版本,拥有6710亿参数,专注于知识类任务和数学推理,性能大幅度提升。V3引入了原生FP8权重,支持本地部署,并且推理速度大幅提升,生成吐字速度从20TPS提升至60TPS,适应了大规模应用的需求。

优势: 强大的推理能力:凭借6710亿参数,DeepSeek-V3在知识推理和数学任务方面展现出卓越的表现。高生成速度:每秒生成60个字符(TPS)的速度使得V3能够满足对响应速度要求高的应用场景。本地部署支持:通过FP8权重的开源,用户可以在本地部署,降低对云服务的依赖,提升数据隐私性。 缺点: 高训练资源需求:虽然推理能力大幅提升,但V3需要大量的GPU资源进行训练,这使得其部署和训练的成本较高。多模态能力不强:和前面版本一样,V3在多模态任务(如图像理解)方面未做专门优化,仍有一定的短板。

6、DeepSeek-R1系列:强化学习与科研应用,性能对标 OpenAI o1 正式版

发布时间:

2025年1月20日

作为一经发布就备受瞩目的DeepSeek-R1来说,真正的是经历了很多磨难才诞生走到现在,而DeepSeek-R1发布以来就秉持这开源的原则,遵循 MIT License,允许用户通过蒸馏技术借助 R1 训练其他模型。

这将有一下两方面的影响:

开源协议层面

MIT License是一种宽松的开源软件许可协议。这意味着DeepSeek - R1以非常开放的姿态面向广大开发者和用户。在遵循MIT License相关规定的前提下,用户拥有极大的自由:

- 使用自由:可以在任何个人项目、商业项目等各种场景中自由使用DeepSeek - R1模型,无需担心因使用场景而产生的法律问题。

- 修改自由:能够对DeepSeek - R1的代码、模型架构等进行修改和定制,以满足特定的业务需求或研究目的。

- 分发自由:可以将基于DeepSeek - R1修改或未修改的版本进行分发,无论是免费分发还是伴随商业产品一起分发都是被允许的。 模型训练与技术应用层面

允许用户通过蒸馏技术借助R1训练其他模型,这具有很高的技术价值和应用潜力:

- 模型轻量化:蒸馏技术可以将大型的DeepSeek - R1模型的知识迁移到小型模型上。开发者能够训练出更轻量级、运行效率更高的模型,比如在资源受限的设备(如移动设备、嵌入式设备等)上部署模型,以实现实时的推理和应用,而无需依赖强大的计算资源来运行大型的DeepSeek - R1原模型。

- 个性化定制:用户可以根据自身特定的任务需求,比如特定领域的文本分类、特定类型的图像识别等,以DeepSeek - R1为基础,通过蒸馏训练出更适配该任务的模型,从而在性能和资源消耗之间取得更好的平衡,提升模型在特定场景下的表现。

- 促进技术创新:这种方式为研究人员和开发者提供了一个强大的工具和起点,鼓励更多人基于DeepSeek - R1进行探索和创新,加速人工智能技术在各个领域的应用和发展,推动整个行业的技术进步。

并且DeepSeek-R1 上线 API,对用户开放思维链输出,通过设置 model=‘deepseek-reasoner’ 即可调用,这无疑极大的方便了很多对于大模型感兴趣的个体用户。

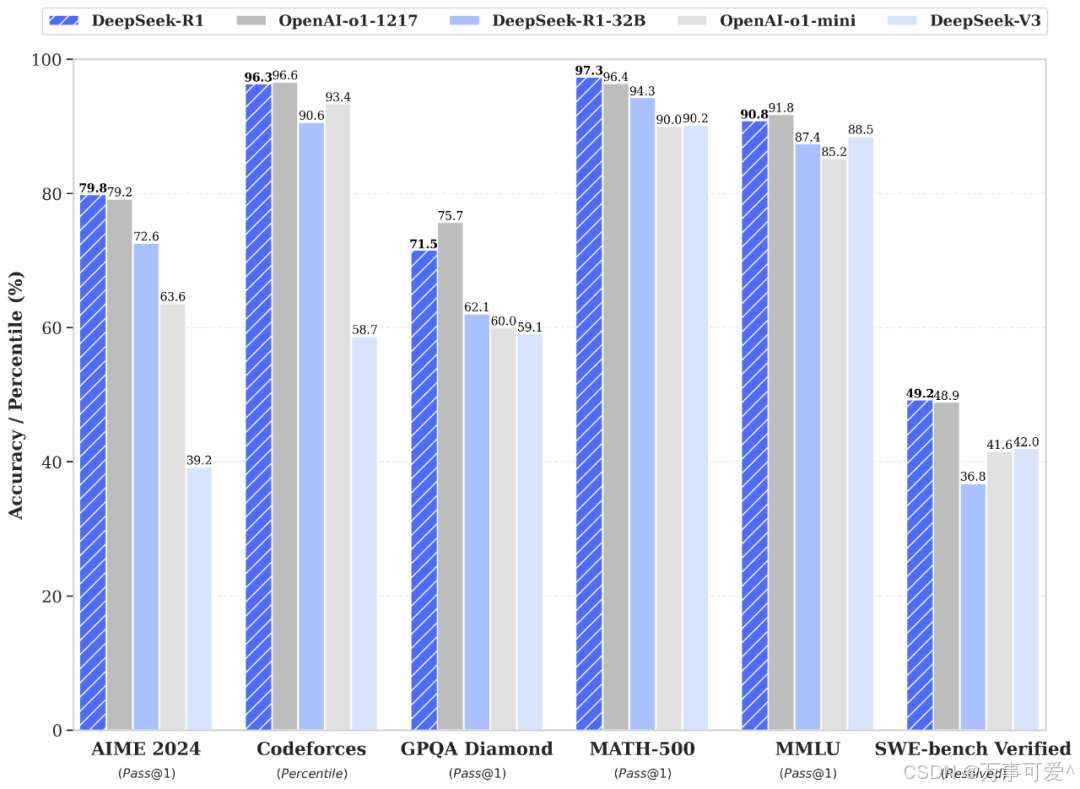

据官网信息透漏,DeepSeek-R1 在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版。

从上图可以看出,在 Codeforces、MATH - 500、SWE - bench Verified 测试中,DeepSeek - R1 或 DeepSeek - R1 - 32B 表现突出;在 AIME 2024、GPQA Diamond、MMLU 测试中,OpenAI - o1 - 1217 表现较好。

但是在蒸馏小模型的对比上,R1模型超越 OpenAI o1-mini。

在官方在开源的数据中 DeepSeek-R1-Zero 和 DeepSeek-R1 两个 660B 模型的同时,通过 DeepSeek-R1 的输出,蒸馏了 6 个小模型开源给社区,其中 32B 和 70B 模型在多项能力上实现了对标 OpenAI o1-mini 的效果。

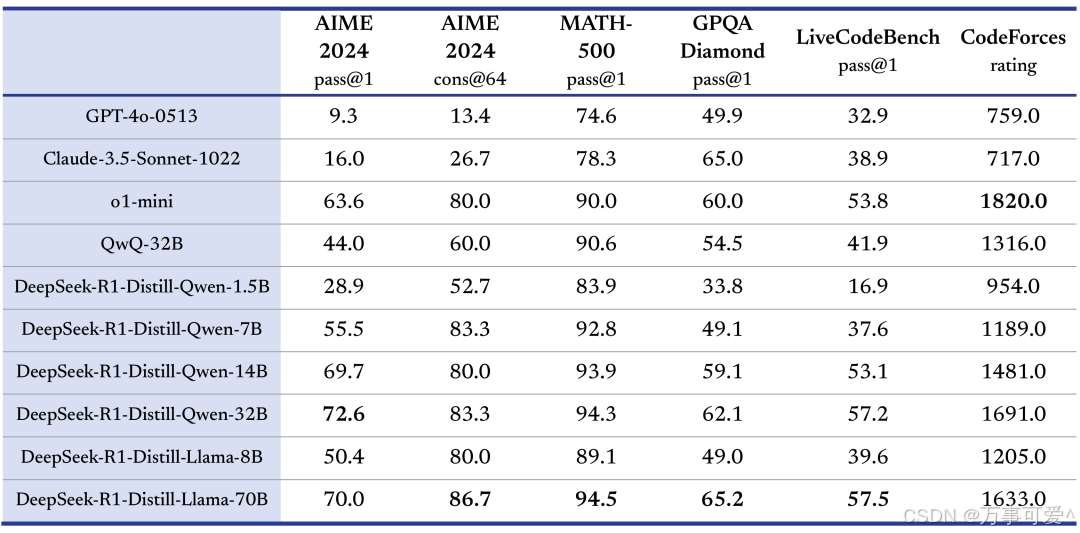

上表为对比不同模型在多项测试集上表现的表格,测试集包括AIME 2024、MATH - 500等,模型有GPT - 4o - 0513、Claude - 3.5 - Sonnet - 1022等,还涉及基于DeepSeek - R1蒸馏的系列模型,具体详情如下的分析:

模型及表现

- GPT - 4o - 0513:在各测试集得分相对均衡,如在AIME 2024 pass@1得分为9.3 ,在CodeForces rating为759.0 。

- Claude - 3.5 - Sonnet - 1022:在各测试表现较稳定,如AIME 2024 pass@1得16.0,CodeForces rating为717.0 。

- o1 - mini:在多个测试集表现突出,尤其在CodeForces rating达到1820.0 。

- QwQ - 32B:在不同测试集有一定表现,如MATH - 500 pass@1得90.6 。

- DeepSeek - R1 - Distill - Qwen系列:随着参数增大(从1.5B到32B),在多数测试集成绩总体提升,如DeepSeek - R1 - Distill - Qwen - 32B在MATH - 500 pass@1得94.3,超过DeepSeek - R1 - Distill - Qwen - 1.5B的83.9 。

- DeepSeek - R1 - Distill - Llama系列:在多项测试表现不错,DeepSeek - R1 - Distill - Llama - 70B在MATH - 500 pass@1得94.5 。

总结

从表格看,o1 - mini在CodeForces竞赛评分上优势明显;DeepSeek - R1蒸馏的大参数模型(如DeepSeek - R1 - Distill - Qwen - 32B、DeepSeek - R1 - Distill - Llama - 70B)在数学和编程相关测试集表现较好,反映出DeepSeek - R1蒸馏技术对模型性能有提升作用,不同模型在各测试集有不同优势。

特点:

DeepSeek-R1是系列中的最新版本,通过强化学习(RL)技术,优化了模型的推理能力。R1版本推理能力接近OpenAI的O1,并且遵循MIT许可证,支持模型蒸馏,进一步促进开源生态的健康发展。

优势:

- 强化学习优化推理能力:利用强化学习技术,R1能够在推理任务中展现出比其他版本更强的表现。

- 开源支持与科研应用:R1完全开源,支持科研人员、技术开发者进行二次开发,推动AI技术的快速进步。

缺点:

- 多模态能力不足:尽管在推理能力上有显著提升,但在多模态任务的支持方面仍未得到充分优化。

- 应用场景受限:R1主要面向科研、技术开发和教育领域,其在商业化应用和实际操作中的适用场景相对较窄。

老样子,R1论文链接以放在下面,供大家学习参考。

论文链接:https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

结语

DeepSeek系列的不断迭代和升级,体现了其在自然语言处理、推理能力和应用生态等方面的持续进步。每个版本都有其独特的优势和适用场景,用户可以根据自身需求选择最适合的版本。随着技术的不断发展,未来DeepSeek可能会在多模态支持、推理能力等方面继续取得突破,值得期待。