您的位置:

>>> TAG标签:pytorch 的结果

-

详解pytorch实现特殊的Module--Sqeuential三种写法

代码如下: # -*- coding: utf-8 -*-#@Time :2019/7/1 13:34#@Author :XiaoMa import torch as tfrom torch import nn#Sequential的三种写法net1=nn.Sequential()net1.add_module(conv,nn.Conv2d(3,3,3)) #Conv2D(输入通道数,输出通道数,卷积核大小)net1.a- 9419

- 2020-01-16

- python

-

详解PyTorch实现AlexNet

PyTorch: https://github.com/shanglianlm0525/PyTorch-Networks 代码如下: import torchimport torch.nn as nnimport torchvision class AlexNet(nn.Module): def __init__(self,num_classes=1000): super(AlexNet,self).__init__() self.feature_extracti- 715

- 2020-01-15

- python

-

PyTorch普通卷积和空洞卷积详解

代码如下: import numpy as npfrom torchvision.transforms import Compose, ToTensorfrom torch import nnimport torch.nn.init as initdef transform(): return Compose([ ToTensor(), # Normalize((12,12,12),std = (1,1,1)), ]) arr = range(1,26)arr =- 1167

- 2020-01-07

- python

-

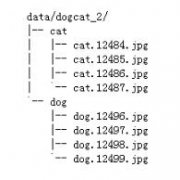

pytorch之ImageFolder使用介绍

pytorch之ImageFolder torchvision已经预先实现了常用的Dataset,包括前面使用过的CIFAR-10,以及ImageNet、COCO、MNIST、LSUN等数据集,可通过诸如torchvision.datasets.CIFAR10来调用。在这里介绍一个会经常使用到的DatasetImageFolder。 ImageFolder假设- 1400

- 2020-01-07

- python

-

pytorch逐元素比较tensor大小

如下所示: import torcha = torch.tensor([[0.01, 0.011], [0.009, 0.9]])mask = a.gt(0.01)print(mask) tensor比较大小可以用tensor.gt属性。上面比较了a中每个元素和0.01的大小,大于0.01的元素输出True。输出结果: tensor([[False, True], [False, True- 655

- 2020-01-04

- python

-

pytorch 改变tensor尺寸的方法

改变Tensor尺寸的操作 1.tensor.view tensor.view方法,可以调整tensor的形状,但必须保证调整前后元素总数一致。view不会改变自身数据,返回的新的tensor与源tensor共享内存,即更改其中一个,另外一个也会跟着改变。 例: In: import torch as t a = t.ar- 1321

- 2020-01-04

- python

-

Pytorch中实现只导入部分模型参数

我们在做迁移学习,或者在分割,检测等任务想使用预训练好的模型,同时又有自己修改之后的结构,使得模型文件保存的参数,有一部分是不需要的(dont expected)。我们搭建的网络对保存文件来说,有一部分参数也是没有的(missed)。如果依旧使用torch.load(- 12931

- 2020-01-02

- python

-

pytorch 归一化与反归一化教程

ToTensor中就有转到0-1之间了。 # -*- coding:utf-8 -*- import time import torch from torchvision import transforms import cv2 transform_val_list = [ # transforms.Resize(size=(160, 160), interpolation=3), # Image.BICUBIC transforms.ToTensor(),- 1587

- 2019-12-31

- python

-

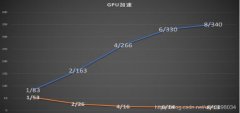

pytorch多GPU训练实例与性能对比分析

以下实验是我在百度公司实习的时候做的,记录下来留个小经验。 多GPU训练 cifar10_97.23 使用 run.sh 文件开始训练 cifar10_97.50 使用 run.4GPU.sh 开始训练 在集群中改变GPU调用个数修改 run.sh 文件 nohup srun --job-name=cf23 $pt --gres=gpu:2 -n1 bas- 1885

- 2019-08-19

- python

-

pytorch使用指定GPU训练的方法

本文适合多GPU的机器,并且每个用户需要单独使用GPU训练。 虽然pytorch提供了指定gpu的几种方式,但是使用不当的话会遇到out of memory的问题,主要是因为pytorch会在第0块gpu上初始化,并且会占用一定空间的显存。这种情况下,经常会出现指定的gpu明明是空- 1402

- 2019-08-19

- python

-

在pytorch中为Module和Tensor指定GPU的例子

pytorch指定GPU 在用pytorch写CNN的时候,发现一运行程序就卡住,然后cpu占用率100%,nvidia-smi 查看显卡发现并没有使用GPU。所以考虑将模型和输入数据及标签指定到gpu上。 pytorch中的Tensor和Module可以指定gpu运行,并且可以指定在哪一块gpu上运行,方法- 1480

- 2019-08-19

- python

-

pytorch使用单个GPU与多个GPU进行训练与测试的教程

如下所示: device = torch.device(cuda:0 if torch.cuda.is_available() else cpu)#第一行代码model.to(device)#第二行代码 首先是上面两行代码放在读取数据之前。 mytensor = my_tensor.to(device)#第三行代码 然后是第三行代码。这句代码的意思是将所有最- 1867

- 2019-08-19

- python

-

将Pytorch模型从CPU转换成GPU的方法教程

最近将Pytorch程序迁移到GPU上去的一些工作和思考 环境:Ubuntu 16.04.3 Python版本:3.5.2 Pytorch版本:0.4.0 0. 序言 大家知道,在深度学习中使用GPU来对模型进行训练是可以通过并行化其计算来提高运行效率,这里就不多谈了。 最近申请到了实验室的服务器- 919

- 2019-08-19

- python

-

pytorch GPU计算过程中出现内存耗尽的问题解决

Pytorch GPU运算过程中会出现:cuda runtime error(2): out of memory这样的错误。通常,这种错误是由于在循环中使用全局变量当做累加器,且累加梯度信息的缘故,用官方的说法就是:accumulate history across your training loop。 在默认情况下,开启梯度- 1672

- 2019-08-19

- python

-

pytorch 更改预训练模型网络结构的教程方法

一个继承nn.module的model它包含一个叫做children()的函数,这个函数可以用来提取出model每一层的网络结构,在此基础上进行修改即可,修改方法如下(去除后两层): resnet_layer = nn.Sequential(*list(model.children())[:-2]) 那么,接下来就可以构建我们的- 1513

- 2019-08-19

- python

-

pytorch打印网络结构的教程

最简单的方法当然可以直接print(net),但是这样网络比较复杂的时候效果不太好,看着比较乱;以前使用caffe的时候有一个网站可以在线生成网络框图,tensorflow可以用tensor board,keras中可以用model.summary()、或者plot_model()。pytorch没有这样的API,- 951

- 2019-08-19

- python

-

在PyTorch中Tensor的查找和筛选方法

本文源码基于版本1.0,交互界面基于0.4.1 import torch 按照指定轴上的坐标进行过滤 index_select() 沿着某tensor的一个轴dim筛选若干个坐标 x = torch.randn(3, 4) # 目标矩阵 xtensor([[ 0.1427, 0.0231, -0.5414, -1.0009], [-0.4664, 0.2647, -0.1228, -- 1109

- 2019-08-18

- python

-

Pytorch Tensor的索引与切片实例

1. Pytorch风格的索引 根据Tensor的shape,从前往后索引,依次在每个维度上做索引。 示例代码: import torch a = torch.rand(4, 3, 28, 28)print(a[0].shape) #取到第一个维度print(a[0, 0].shape) # 取到二个维度print(a[1, 2, 2, 4]) # 具体到某个元素 上- 839

- 2019-08-18

- python

-

PyTorch之图像和Tensor填充的实例

在PyTorch中可以对图像和Tensor进行填充,如常量值填充,镜像填充和复制填充等。在图像预处理阶段设置图像边界填充的方式如下: import vision.torchvision.transforms as transforms img_to_pad = transforms.Compose([ transforms.Pad(padding=2, padding_- 1869

- 2019-08-18

- python

-

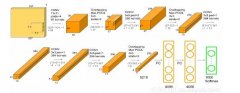

Pytorch实现GoogLeNet的方法

GoogLeNet也叫InceptionNet,在2014年被提出,如今已到V4版本。GoogleNet比VGGNet具有更深的网络结构,一共有22层,但是参数比AlexNet要少12倍,但是计算量是AlexNet的4倍,原因就是它采用很有效的Inception模块,并且没有全连接层。 最重要的创新点就在于使- 1542

- 2019-08-18

- python

-

解析PyTorch中nn.Linear的使用

Linear 的初始化部分: class Linear(Module): ... __constants__ = [bias] def __init__(self, in_features, out_features, bias=True): super(Linear, self).__init__() self.in_features = in_features self.out_features = out_features self.weight = P- 1647

- 2019-08-18

- python

-

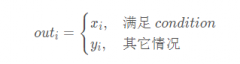

PyTorch中Tensor的高阶操作解析

条件选取:torch.where(condition, x, y) Tensor 返回从 x 或 y 中选择元素的张量,取决于 condition 操作定义: 举个例子: import torch c = randn(2, 3) ctensor([[ 0.0309, -1.5993, 0.1986], [-0.0699, -2.7813, -1.1828]]) a = torch.ones(2, 3) atens- 1642

- 2019-08-18

- python

-

PyTorch中Tensor的拼接与拆分的实现

拼接张量:torch.cat() 、torch.stack() torch.cat(inputs, dimension=0) Tensor 在给定维度上对输入的张量序列 seq 进行连接操作 举个例子: import torch x = torch.randn(2, 3) xtensor([[-0.1997, -0.6900, 0.7039], [ 0.0268, -1.0140, -2.9764]]) torc- 1469

- 2019-08-18

- python

-

PyTorch中Tensor的维度变换实现方法

对于 PyTorch 的基本数据对象 Tensor (张量),在处理问题时,需要经常改变数据的维度,以便于后期的计算和进一步处理,本文旨在列举一些维度变换的方法并举例,方便大家查看。 维度查看:torch.Tensor.size() 查看当前 tensor 的维度 举个例子: import torc- 1070

- 2019-08-18

- python

-

Pytorch中的torch.gather函数的含义解析

pytorch中的gather函数 pytorch比tensorflow更加编程友好,所以准备用pytorch试着做最近要做的一些实验。 立个flag开始学习pytorch,新开一个分类整理学习pytorch中的一些踩到的泥坑。 今天刚开始接触,读了一下documentation,写一个一开始每太搞懂的函数ga- 1833

- 2019-08-18

- python

-

pytorch索引查找 index_select的实例

index_select anchor_w = self.FloatTensor(self.scaled_anchors).index_select(1, self.LongTensor([0])) 参数说明:index_select(x, 1, indices) 1代表维度1,即列,indices是筛选的索引序号。 例子: import torch x = torch.linspace(1, 12, steps=12).v- 788

- 2019-08-18

- python

-

pytorch 输出中间层特征的示例

pytorch 输出中间层特征: tensorflow输出中间特征,2种方式: 1. 保存全部模型(包括结构)时,需要之前先add_to_collection 或者 用slim模块下的end_points 2. 只保存模型参数时,可以读取网络结构,然后按照对应的中间层输出即可。 but:Pytorch 论坛给出的- 1314

- 2019-08-18

- python

-

pytorch 模型可视化的实例

如下所示: 一. visualize.py from graphviz import Digraphimport torchfrom torch.autograd import Variable def make_dot(var, params=None): Produces Graphviz representation of PyTorch autograd graph Blue nodes are the Variables that require gr- 569

- 2019-08-18

- python

-

Pytorch反向求导更新网络参数的教程

方法一:手动计算变量的梯度,然后更新梯度 import torchfrom torch.autograd import Variable# 定义参数w1 = Variable(torch.FloatTensor([1,2,3]),requires_grad = True)# 定义输出d = torch.mean(w1)# 反向求导d.backward()# 定义学习率等参数lr = 0.001#- 1497

- 2019-08-18

- python

热门文章

-

非常献身者:中国“钱商”的

2018-12-20

-

新瓶装旧酒 哪些SEO优化方式适

2018-01-12

-

OPPO和VIVO45充50话费

2021-05-07

-

新网5.1买cn域名9.9买虚拟主机

2021-05-08

-

百度是下一个雅虎吗?

2019-06-06

-

未来的“双11” 阿里还手握哪

2018-11-22

排行榜

- 每日

- 周榜

-

-

- 1 SpringBoot将多个文件夹进行压缩的两种方法(浏览器下载和另存为

- 2 Win11 26120.1350 Dev 预览版更新补丁KB5041871(附更新内容汇总)

- 3 golang interface指针实现

- 4 Win11中设置和管理虚拟内存的教程 win11设置虚拟内存有什么用?

- 5 在Mac桌面上使用小组件的方法! macOS Sonoma 怎么添加桌面小部件

- 6 Win11系统BitLocker设备加密怎么打开或关闭?

- 7 如何置重导入和导出Win10默认应用程序关联配置

- 8 css边框修饰的实现

- 9 SpringBoot集成slf4j2日志配置的实现

- 10 Flatpak和Snapcraft怎么选? Linux软件包管理系统优缺点对比

-