在深度学习中,池化层(Pooling Layer)是卷积神经网络(CNN)中的关键组成部分。池化层的主要功能是对特征图进行降维和减少计算量,同时增强模型的鲁棒性。本文将详细介绍池化层的作用、种类、实现方法,并对比其与卷积层的异同,以及深入探讨全局池化的应用。

1. 池化层的作用

池化层的核心作用包括以下几个方面:

- 降维:通过池化操作,可以减少特征图的空间尺寸(高度和宽度),从而降低计算复杂度。

- 特征提取:池化层保留局部区域的显著特征,如边缘、纹理等。

- 抑制噪声:池化操作可以抑制输入特征图中的局部噪声,提高模型的鲁棒性。

- 防止过拟合:通过减少特征图的尺寸和参数数量,池化层有助于防止模型过拟合。

2. 池化层的类型

池化层主要包括最大池化(Max Pooling)和平均池化(Average Pooling),此外还有全局池化(Global Pooling)。

2.1 最大池化(Max Pooling)

最大池化选取池化窗口内的最大值作为输出。这种方法能够保留特征图中最显著的特征,通常用于提取边缘等强特征。

|

1 2 3 4 5 6 7 8 9 10 11 12 |

import torch import torch.nn as nn # 创建一个二维最大池化层,池化窗口大小为2x2,步幅为2x2 maxpool2d = nn.MaxPool2d(kernel_size=2, stride=2) # 输入数据为 (batch_size, channels, height, width) input_tensor = torch.tensor([[[[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12], [13, 14, 15, 16]]]], dtype=torch.float32) # 进行池化操作 output_tensor = maxpool2d(input_tensor) print(output_tensor) |

输出结果为:

tensor([[[[ 6., 8.],

[14., 16.]]]])

2.1.1 最大池化的详细计算过程

最大池化(Max Pooling)是一种常见的池化操作,用于对输入特征图进行降维和特征提取。其核心思想是通过池化窗口(也称为滤波器)在特征图上滑动,并在每个窗口内选取最大值作为该窗口的输出,从而形成一个新的、尺寸较小的特征图。

1. 池化窗口(Pooling Window)

池化窗口是一个固定大小的矩形区域,通常用kernel_size参数指定。例如,kernel_size=2表示一个2x2的池化窗口。池化窗口在特征图上滑动,滑动的步幅用stride参数指定。例如,stride=2表示池化窗口每次滑动2个单位。

2. 操作过程

假设我们有一个输入特征图,每个池化窗口覆盖特征图的一部分,最大池化的具体操作步骤如下:

- 选择窗口位置:将池化窗口放置在特征图的左上角,覆盖一个kernel_size大小的区域。

- 计算最大值:在这个窗口内,找出所有元素的最大值。记录结果:将这个最大值记录到输出特征图的对应位置。

- 滑动窗口:按照stride参数指定的步幅,滑动池化窗口到新的位置,重复步骤2和步骤3,直到整个特征图都被池化窗口覆盖。

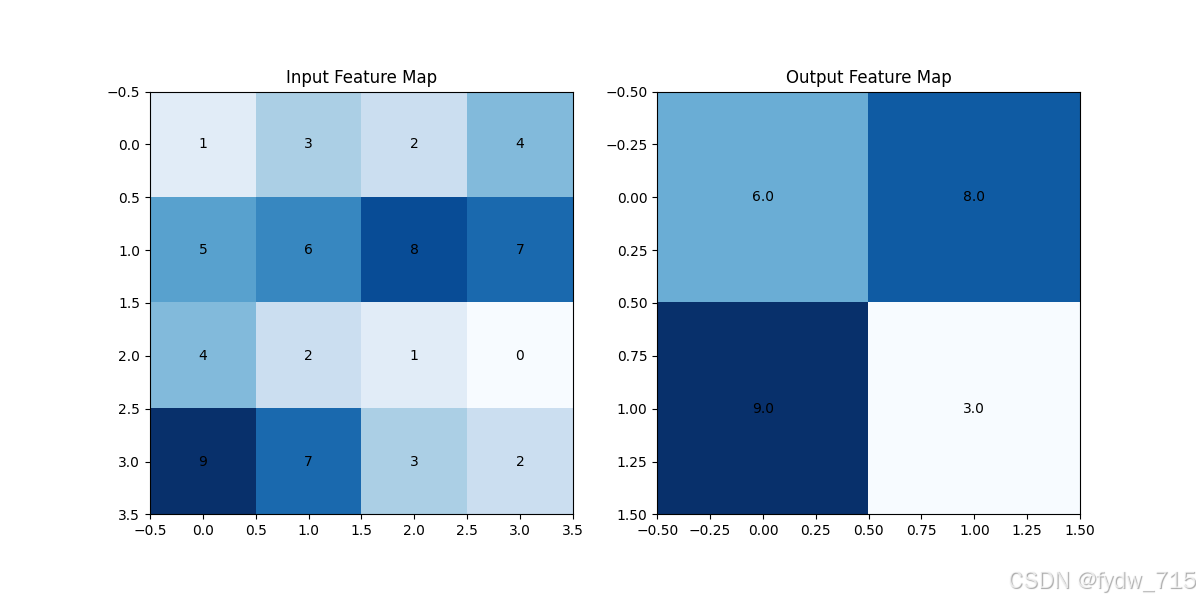

3. 示例

假设我们有一个4x4的特征图,池化窗口大小为2x2,步幅为2。具体操作如下:

输入特征图:

[[1, 3, 2, 4],

[5, 6, 8, 7],

[4, 2, 1, 0],

[9, 7, 3, 2]]

池化过程:

第一个窗口覆盖位置(左上角2x2):

[[1, 3],

[5, 6]]

最大值为6。第二个窗口覆盖位置(右上角2x2):

[[2, 4],

[8, 7]]

最大值为8。第三个窗口覆盖位置(左下角2x2):

[[4, 2],

[9, 7]]

最大值为9。第四个窗口覆盖位置(右下角2x2):

[[1, 0],

[3, 2]]

最大值为3。

输出特征图:

[[6, 8],

[9, 3]]

4. 代码实现

以下是使用PyTorch实现上述最大池化操作的代码示例:

|

1 2 3 4 5 6 7 8 9 10 11 12 |

import torch import torch.nn as nn # 定义一个2x2的最大池化层,步幅为2 maxpool2d = nn.MaxPool2d(kernel_size=2, stride=2) # 输入数据 (1, 1, 4, 4) 表示 (batch_size, channels, height, width) input_tensor = torch.tensor([[[[1, 3, 2, 4], [5, 6, 8, 7], [4, 2, 1, 0], [9, 7, 3, 2]]]], dtype=torch.float32) # 进行池化操作 output_tensor = maxpool2d(input_tensor) print(output_tensor) |

输出结果为:

tensor([[[[6., 8.],

[9., 3.]]]])

2.2 平均池化(Average Pooling)

平均池化计算池化窗口内的平均值作为输出。它能够平滑特征图,通常用于减少噪声。

|

1 2 3 4 5 6 7 8 9 10 11 12 |

import torch import torch.nn as nn # 创建一个二维平均池化层,池化窗口大小为2x2,步幅为2x2 avgpool2d = nn.AvgPool2d(kernel_size=2, stride=2) # 输入数据为 (batch_size, channels, height, width) input_tensor = torch.tensor([[[[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12], [13, 14, 15, 16]]]], dtype=torch.float32) # 进行池化操作 output_tensor = avgpool2d(input_tensor) print(output_tensor) |

输出结果为:

tensor([[[[ 3.5, 5.5],

[11.5, 13.5]]]])

3. 全局池化(Global Pooling)

全局池化是一种特殊的池化操作,它将整个特征图缩小为一个单独的值。全局池化通常用于卷积神经网络的最后一个池化层,目的是将特征图的空间维度完全去除,从而得到一个固定大小的输出。这对于连接全连接层(Fully Connected Layer)或进行分类任务非常有用。

3.1 全局平均池化(Global Average Pooling)

全局平均池化计算整个特征图的平均值。

|

1 2 3 4 5 6 7 8 9 10 11 12 |

import torch import torch.nn as nn # 定义一个全局平均池化层 global_avgpool = nn.AdaptiveAvgPool2d((1, 1)) # 输入数据 (batch_size, channels, height, width) input_tensor = torch.tensor([[[[1, 3, 2, 4], [5, 6, 8, 7], [4, 2, 1, 0], [9, 7, 3, 2]]]], dtype=torch.float32) # 进行全局平均池化操作 output_tensor = global_avgpool(input_tensor) print("全局平均池化后的特征图:", output_tensor) |

输出结果为:

全局平均池化后的特征图: tensor([[[[4.2500]]]])

3.2 全局最大池化(Global Max Pooling)

全局最大池化计算整个特征图的最大值。

|

1 2 3 4 5 6 7 8 9 10 11 12 |

import torch import torch.nn as nn # 定义一个全局最大池化层 global_maxpool = nn.AdaptiveMaxPool2d((1, 1)) # 输入数据 (batch_size, channels, height, width) input_tensor = torch.tensor([[[[1, 3, 2, 4], [5, 6, 8, 7], [4, 2, 1, 0], [9, 7, 3, 2]]]], dtype=torch.float32) # 进行全局最大池化操作 output_tensor = global_maxpool(input_tensor) print("全局最大池化后的特征图:", output_tensor) |

输出结果为:

全局最大池化后的特征图: tensor([[[[9.]]]])

3.3 全局池化的应用

全局池化在深度学习模型中有许多应用,特别是在卷积神经网络(CNN)中。以下是一些常见的应用场景:

简化模型结构:全局池化可以将特征图的空间维度完全去除,从而简化模型结构。这使得模型在处理不同尺寸的输入时更加灵活。减少参数:全局池化可以减少全连接层的参数数量,因为它将特征图缩小为一个固定大小的输出。这有助于降低模型的复杂度和过拟合风险。提高模型的泛化能力:全局池化通过聚合整个特征图的信息,可以提高模型的泛化能力,使其在不同数据集上表现更好。 3.4 全局池化与传统池化的对比

| 特性 | 传统池化(如 MaxPool2d, AvgPool2d) | 全局池化(Global Pooling) |

|---|---|---|

| 池化窗口大小 | 固定大小(如 2x2, 3x3) | 覆盖整个特征图 |

| 输出尺寸 | 依据池化窗口大小和步幅 | 固定为 1x1 |

| 主要用途 | 局部特征提取和降维 | 全局特征聚合和降维 |

| 计算复杂度 | 较低 | 较低 |

| 参数数量 | 无参数 | 无参数 |

4. 池化层和卷积层的对比

池化层和卷积层在使用滑动窗口和降维方面有相似之处,但它们的功能和作用不同。

相似之处

- 滑动窗口(Kernel):两者都使用固定大小的窗口在特征图上滑动。

- 降维:两者都可以通过设置适当的步幅(stride)来减少特征图的空间尺寸。

- 步幅(Stride):两者都可以设置步幅来控制滑动窗口的移动步长,从而影响输出特征图的大小。

不同之处

操作性质:

- 池化层:主要用于降维和特征选择,操作较为简单(如最大值或平均值计算)。池化层无参数更新,不涉及学习过程。

- 卷积层:用于特征提取,通过卷积运算捕捉局部特征。卷积层包含可学习的参数(卷积核),这些参数通过反向传播进行更新。

输出特征图的内容:

- 池化层:输出的特征图是输入特征图的一种精简表示,保留了局部区域的显著特征(如最大值或平均值)。

- 卷积层:输出的特征图是通过卷积核的加权求和得到的,能够捕捉到输入特征图的不同特征(如边缘、纹理等)。

学习能力:

- 池化层:无学习能力,不含可学习的参数。

- 卷积层:具有学习能力,卷积核参数通过训练过程进行优化。

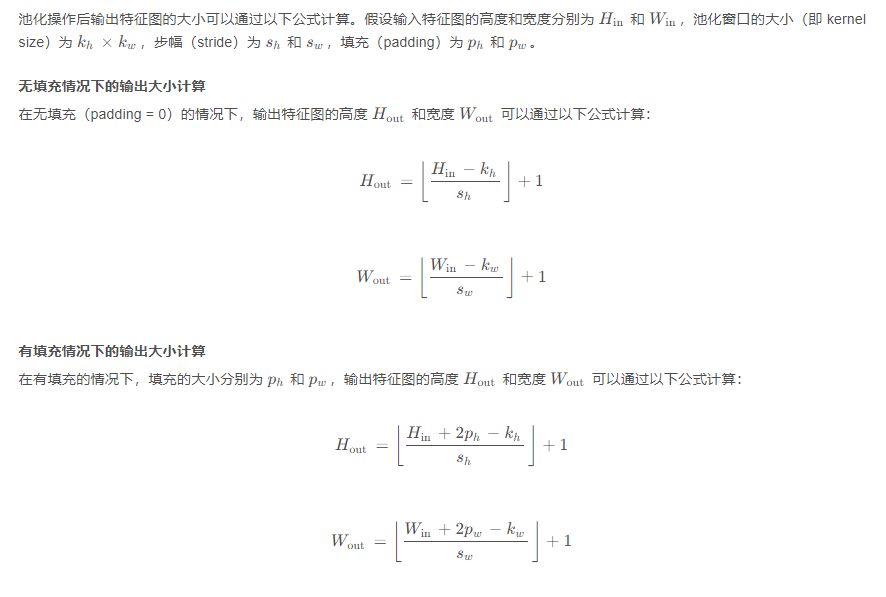

5. 计算输出特征图的大小

总结

池化层在深度学习中扮演着重要角色,通过降维、特征提取和抑制噪声等功能,显著提高了模型的计算效率和鲁棒性。最大池化和平均池化是最常见的池化操作,而全局池化作为一种特殊的池化方法,在简化模型结构和提高泛化能力方面表现突出。了解池化层的工作原理和应用,对于设计和优化高效的深度学习模型至关重要。