为了实验大数据的导出,我们这里先自已创建一张大表,表结构如下:

|

1

2

3

4

5

6

7

8

9

10

11

|

CREATE TABLE `tb_users` ( `id` int(11) unsigned NOT NULL AUTO_INCREMENT COMMENT '用户ID', `name` varchar(32) DEFAULT '' COMMENT '用户名', `age` tinyint(3) DEFAULT '0' COMMENT '用户年龄', `desc` varchar(255) DEFAULT '' COMMENT '用户描述', `phone` varchar(11) DEFAULT '' COMMENT '用户手机', `qq` varchar(16) DEFAULT '' COMMENT '用户QQ', `email` varchar(64) DEFAULT '' COMMENT '用户邮箱', `addr` varchar(255) DEFAULT '' COMMENT '用户地址', PRIMARY KEY (`id`)) ENGINE=InnoDB DEFAULT CHARSET=utf8; |

然后写个php脚本往这个表插入数据,代码如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

|

<?phpset_time_limit(0);ini_set('memory_limit', '128M');//使用TP3.2的String类,php7下会报错,注意把类名换一下require './String.class.php';use Org\Util\NewString;$begin = microtime(true);$db = new mysqli('127.0.0.1', 'root', '', 'test');if($db->connect_error) { die('connect error');}//数据插入语句$insSql = '';//一百万数据,分200步,每步插入5000条$step = 200;$nums = 5000;for($s = 0; $s < $step; ++$s) { $insSql = 'INSERT INTO tb_users VALUES'; for($n = 0; $n < $nums; ++$n) { $name = NewString::randString(3, 4); $age = mt_rand(1, 120); $desc = NewString::randString(64, 4); $phone = NewString::randString(11, 1); $qq = NewString::randString(13, 1); $email = $qq . '@qq.com'; $addr = NewString::randString(128, 4); $insSql .= "(NULL, '{$name}', $age, '{$desc}', '{$phone}', '{$qq}', '{$email}', '{$addr}'),"; } $insSql = rtrim($insSql, ','); $db->query($insSql);}$end = microtime(true);echo '用时:', $end - $begin;$db->close(); |

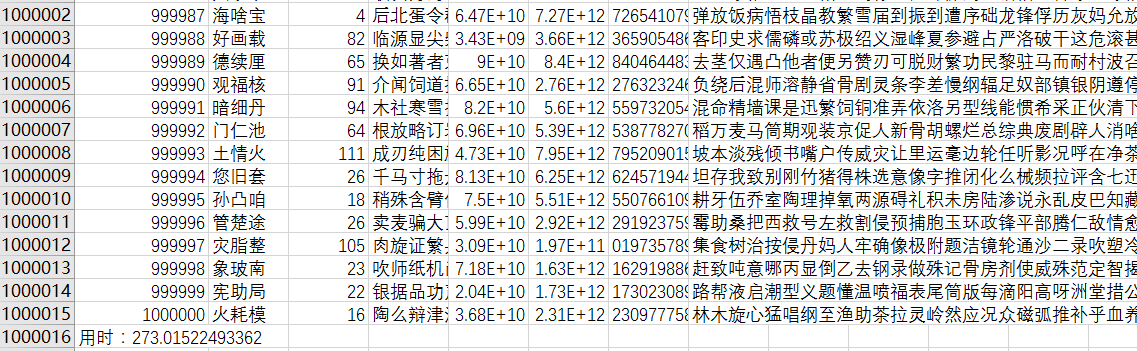

里面用到的TP3.2的String类大家自行上TP官网下载。整个用时2个多小时,最后数据大小662M。

现在我们用php提供的fputcsv来导出这一百万的数据,原理就是打开一个标准输出流,然后把数据按一万条来分割,每一万条就刷新缓冲区。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

|

<?phpset_time_limit(0);ini_set('memory_limit', '128M');$fileName = date('YmdHis', time());header('Content-Type: application/vnd.ms-execl');header('Content-Disposition: attachment;filename="' . $fileName . '.csv"');$begin = microtime(true);//打开php标准输出流//以写入追加的方式打开$fp = fopen('php://output', 'a');$db = new mysqli('127.0.0.1', 'root', '', 'test');if($db->connect_error) { die('connect error');}//我们试着用fputcsv从数据库中导出1百万的数据//我们每次取1万条数据,分100步来执行//如果线上环境无法支持一次性读取1万条数据,可把$nums调小,$step相应增大。$step = 100;$nums = 10000;//设置标题$title = array('ID', '用户名', '用户年龄', '用户描述', '用户手机', '用户QQ', '用户邮箱', '用户地址');foreach($title as $key => $item) { $title[$key] = iconv('UTF-8', 'GBK', $item);}//将标题写到标准输出中fputcsv($fp, $title);for($s = 1; $s <= $step; ++$s) { $start = ($s - 1) * $nums; $result = $db->query("SELECT * FROM tb_users ORDER BY id LIMIT {$start},{$nums}"); if($result) { while($row = $result->fetch_assoc()) { foreach($row as $key => $item) { //这里必须转码,不然会乱码 $row[$key] = iconv('UTF-8', 'GBK', $item); } fputcsv($fp, $row); } $result->free(); //每1万条数据就刷新缓冲区 ob_flush(); flush(); }}$end = microtime(true);echo '用时:', $end - $begin; |

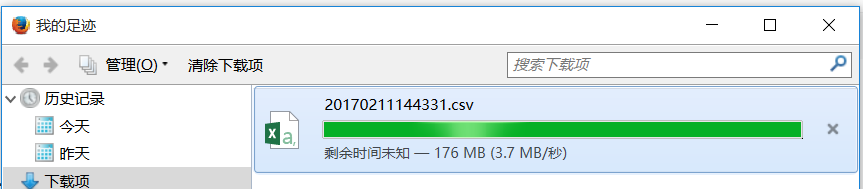

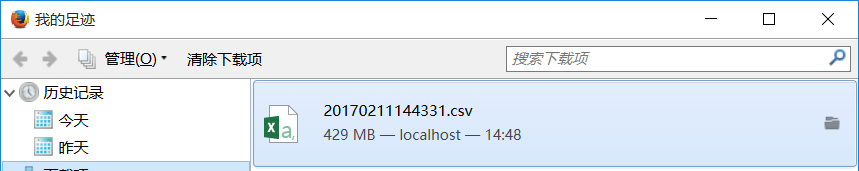

整个过程用时5分钟,最终生成的csv文件大小420M。

对于如何用phpexcel导出大数据,并没有什么比较好的方案,phpexcel提供的一些缓存方法,数据压缩,虽然内存使用小了,但所用时间则加长了,时间换空间,显然并不是最好的方案。比较靠谱的方法还是生成多个下载链接地址,把你要下载的数据,以get形式传递当前页数,后台进行数据分页然后导出。

|

1

2

3

|

<a href="/downSearchData.php?参数1=值1&参数2=值2&page=1" rel="external nofollow" >下载汇总结果1</a><a href="/downSearchData.php?参数1=值1&参数2=值2&page=2" rel="external nofollow" >下载汇总结果2</a><a href="/downSearchData.php?参数1=值1&参数2=值2&page=3" rel="external nofollow" >下载汇总结果3</a> |

比如你有一个查询数据表单,ID为searchFrm,然后你想把导出数据按1万条分割(phpexcel一次导出1万条是没有问题的,效率还行)

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

<form id="searchFrm"> 姓名<input type="text" name="uname"> <input type="button" id="searchDataBtn" value="导出汇总结果"></form><div id="searchDataList"></div><script type="script"> $("#searchDataBtn").on("click", function() { var params = $("#searchFrm").serialize(); //获取查询数据的条数 $.get("/getSearchDataRows?" + params, function(data) { var downDataList = ""; if(data["rows"]) { //rows是数据总条数,pageSize是一页多少条 var pageNum = Math.ceil(data["rows"] / data["pageSize"]); for(var i = 1; i <= pageNum; ++i) { downDataList += "<a href='/downSearchData.php?'" + params + "&page=" + i + ">下载汇总结果" + i + "</a> "; } $("#searchDataList").html(downDataList); } else { $("#searchDataList").text("没有数据"); } }, "json"); return false; });</script> |

原文链接:https://www.cnblogs.com/jkko123/p/6389240.html

相关文章