解决DeepSeek服务器繁忙问题

三:最为推荐

一、用户端即时优化方案

网络加速工具

推荐使用迅游加速器或海豚加速器优化网络路径,缓解因网络拥堵导致的连接问题。以迅游为例:

启动加速器后搜索"DeepSeek"专项加速输入口令DS111可领取免费加速时长(海豚加速器适用)

清理浏览器缓存与切换设备

在Chrome/Firefox中清理缓存(设置→隐私和安全→删除浏览数据)尝试手机APP访问或使用无痕模式(Chrome按Ctrl+Shift+N)

错峰使用策略

避开工作日早晚高峰(10:00-12:00, 19:00-22:00),建议在凌晨1:00-6:00使用

二、高级技术方案

本地化部署

通过海豚加速器或迅游的「一键本地部署」功能实现:

- 选择本地部署工具后自动安装模型

- 部署完成后直接在终端对话(需30GB以上存储空间)

API调用与第三方平台

- 通过硅基流动、秘塔AI等平台调用DeepSeek模型(需注册账号)

- 使用AnythingLLM等开源工具搭建私有数据库

三、替代方案与平替工具(最推荐简单好用)

若问题持续存在,可考虑以下替代服务:

| 工具名称 | 特点 | 访问方式 |

|---|---|---|

| 纳米AI搜索 | 集成DeepSeek R1模型 | https://nano.ai |

| 硅基流动 | 支持多模态深度思考 | https://siliconflow.com |

| 秘塔AI | 内置R1满血版推理引擎 | 微信小程序搜索"秘塔AI" |

四、系统层建议与官方动态

服务器负载现状

根据2月13日最新分析,DeepSeek日活已突破4000万(达ChatGPT的74.3%),但自建数据中心算力不足导致频繁卡顿1113。

官方应对措施

- 正在扩充GPU集群(预计2月底新增10万台A100服务器)

- 每日10:00-12:00进行负载均衡优化

- 推荐用户订阅Pro版获得优先响应权

建议优先尝试本地部署+加速器组合方案,若需持续稳定使用可考虑订阅企业版($20/月享专属服务器通道)。当前问题预计在2025年3月算力扩容完成后显著缓解。

用加速器本地部署DeepSeek

使用加速器本地部署DeepSeek的完整指南

一、核心原理与工具选择

通过加速器实现本地部署的本质是:利用网络优化工具解决模型下载/API通信问题,配合部署框架实现离线运行。当前主流方案分为两类:

全托管式部署(推荐新手)

使用迅游/海豚等集成工具包,实现"加速+部署"一体化操作

- 优势:无需手动配置环境,自动适配硬件

- 适用场景:个人快速部署、低代码需求

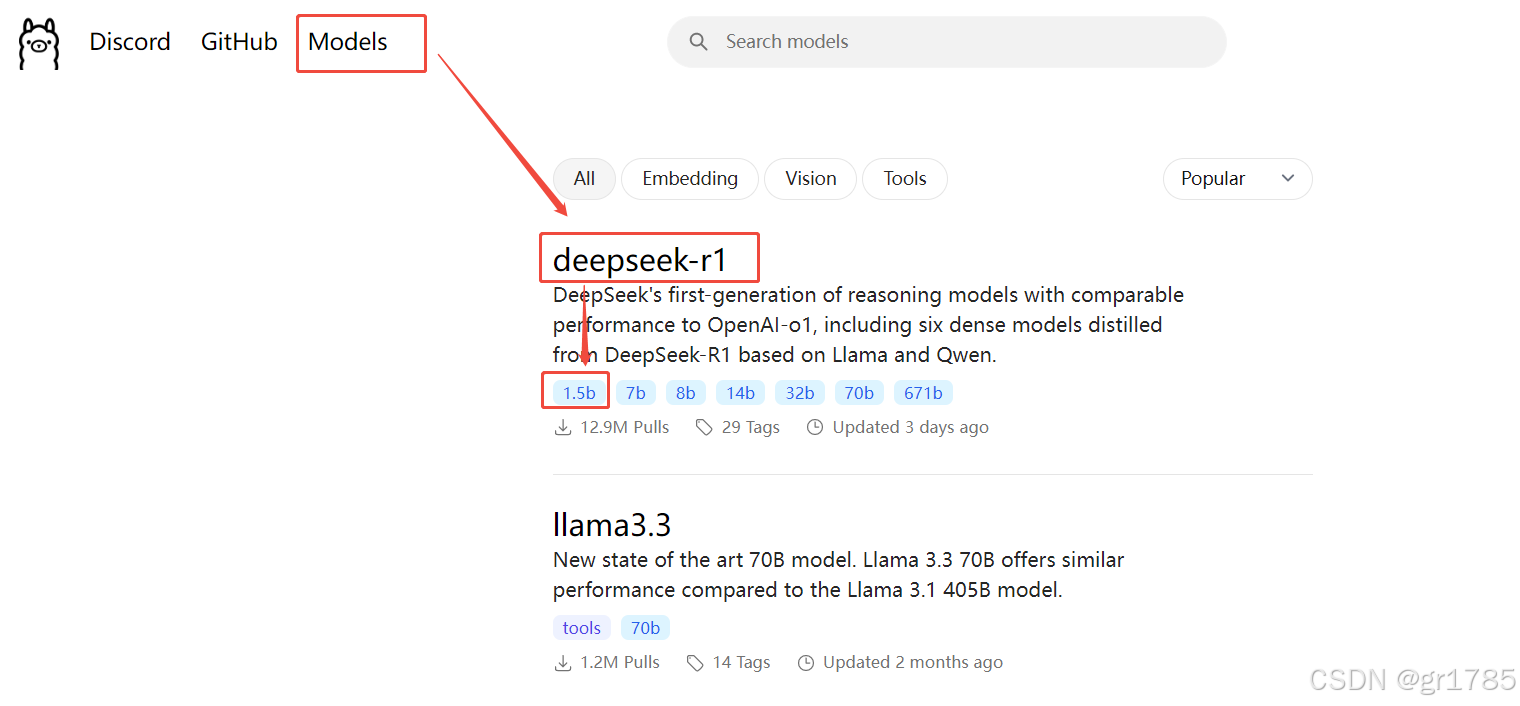

半自动部署(适合开发者)

通过加速器优化Ollama下载,再手动执行部署命令48

- 优势:可自定义模型版本与存储路径

- 适用场景:企业级定制、多模型管理

二、迅游加速器全托管方案

步骤说明(Windows/Mac通用):

安装与加速

- 访问迅游官网下载客户端(v5.2.1+)

- 搜索"DeepSeek" → 点击「立即加速」启动专用通道

一键部署操作

- 在加速页面找到「一键本地部署」按钮

- 选择模型版本(推荐配置对照表):

| 模型版本 | 显存需求 | 存储空间 | 适用场景 |

|---|---|---|---|

| 7B | 8GB | 4.7GB | 日常对话/文案生成 |

| 32B | 16GB | 20GB | 复杂推理/代码开发 |

部署验证

- 完成部署后自动弹出终端窗口

- 输入测试命令:ollama run deepseek-r1:7b → 输入简单问题验证响应速度

注意项:

- 若遇C盘空间不足,需提前在设置中修改默认存储路径(仅支持NTFS格式分区)

- 部署过程中保持加速器处于运行状态(断开会导致模型损坏)

三、海豚加速器+Ollama手动部署

高阶操作流程:

网络加速配置

- 安装海豚加速器后,在「工具箱」→「AI加速」启用DeepSeek专线7

- 输入口令DS111领取5天VIP加速时长(提升下载速度300%+)

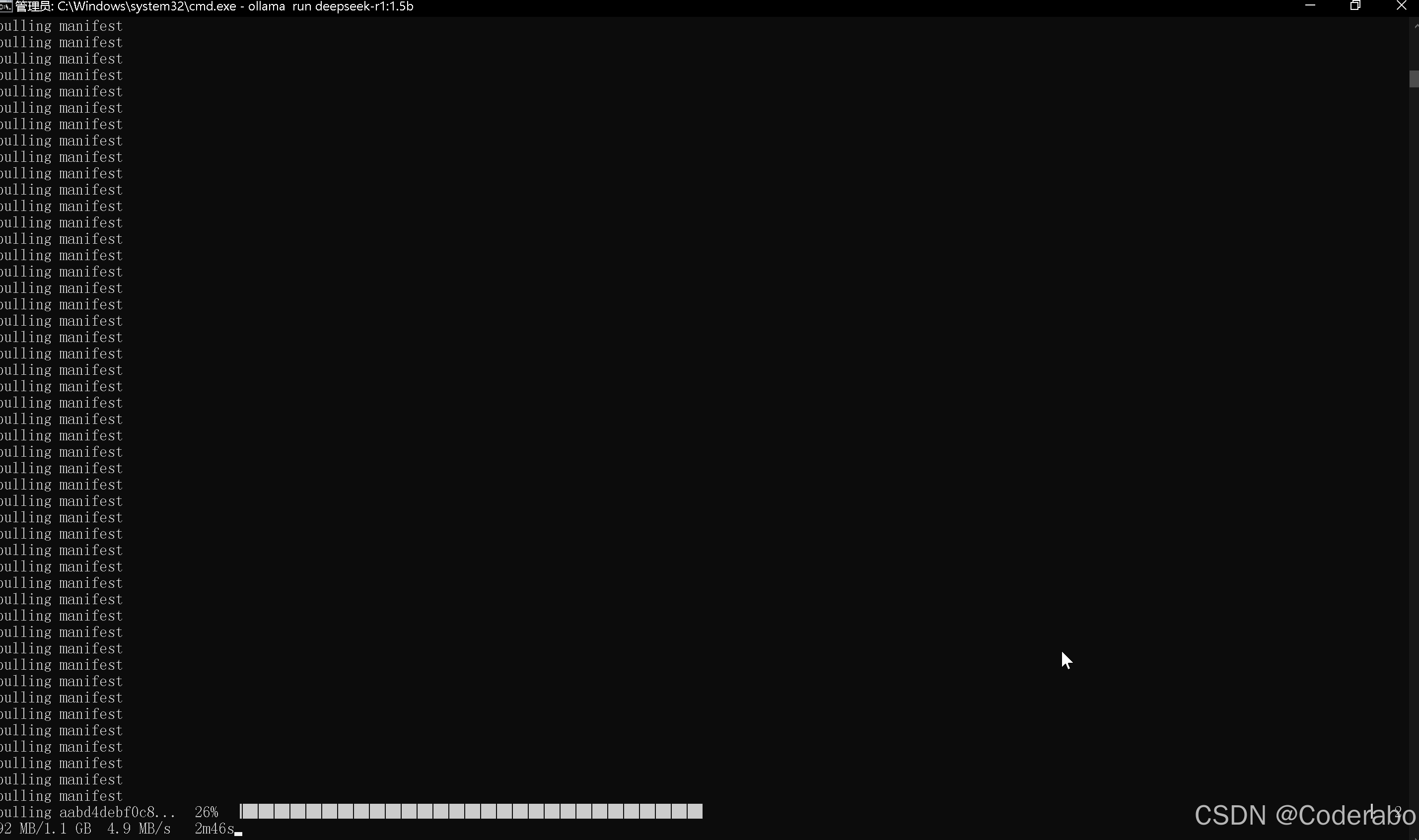

Ollama环境部署

# Windows PowerShell(管理员) winget install ollama ollama --version # 验证安装(需返回v0.5.2+)

?

|

1 2 3 |

3. **加速下载模型** ```bash ollama run deepseek-r1:7b --accelerator=dolphin # 调用海豚加速通道 |

启动本地服务

ollama serve # 默认端口11434

?

|

1 2 3 4 5 6 7 8 9 10 |

**故障排查:** - 若出现`Error: model not found`,执行: `export OLLAMA_HOST=0.0.0.0:11434`(Linux/Mac)[4]() - GPU未被识别时,运行: `nvidia-smi`确认驱动状态 → 重装CUDA 12.1+[10]() #### 四、性能优化建议 1. **硬件加速配置** - NVIDIA用户启用CUDA加速: ```bash ollama run deepseek-r1:7b --gpu 0 # 指定第1块GPU |

AMD显卡使用ROCm:

安装ROCm 5.6+后添加--rocm参数8 内存优化技巧 调整交换分区(Linux):

sudo fallocate -l 16G /swapfile sudo chmod 600 /swapfile sudo mkswap /swapfile sudo swapon /swapfile

?

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 |

- Windows用户设置虚拟内存为物理内存的2倍[8]() #### 五、部署后管理 1. **常用命令速查** | 命令 | 功能描述 | |--------------------------|------------------------------| | `ollama list` | 查看已安装模型 | | `ollama rm deepseek-r1` | 删除指定模型 | | `ollama pull deepseek-r1:14b` | 升级模型版本 | 2. **可视化界面推荐** - Chatbox(跨平台GUI): 下载地址:https://chatbox.space → 连接`http://localhost:11434`[4]() - AnythingLLM(企业级): 支持多模型切换与知识库集成[7]() **典型问题解决方案:** - 部署后响应慢 → 检查`nvidia-smi`的GPU利用率,确认CUDA已启用 - 对话中断 → 执行`ollama serve --verbose`查看详细日志 - 存储空间不足 → 使用`ollama prune`清理旧版本模型[8]() 通过以上步骤,用户可在15分钟内完成从加速器配置到本地服务的完整部署。建议首次部署选择7B版本进行验证,后续根据实际需求升级更高阶模型。 |