AI对话中的“停止生成”与“重新回答”交互逻辑和实现方法

在当前的AI应用开发浪潮中,很多从传统Web转型AI的开发者(包括曾经的我)容易陷入一个误区:认为只要调通了LLM的API,把文本渲染到页面上,工作就完成了。然而,在实际的商业落地场景中

|

在当前的AI应用开发浪潮中,很多从传统Web转型AI的开发者(包括曾经的我)容易陷入一个误区:认为只要调通了LLM的API,把文本渲染到页面上,工作就完成了。然而,在实际的商业落地场景中,用户对于交互的掌控感有着极高的要求。 试想一下,当用户发现提问有误,或者AI开始“胡说八道”时,如果必须等待它慢吞吞地输出完几百个字才能进行下一步操作,这种体验是灾难性的。今天我们就来聊聊如何通过“停止生成”与“重新回答”这两个看似简单的功能,精准捕捉用户意图,提升AI产品的交互质感。 一、背景与痛点:流式传输下的“失控感”在传统的HTTP请求中,前端发送请求,等待响应,是一次性的“原子操作”。但在AI对话中,为了追求类似ChatGPT的打字机效果,我们普遍采用了Server-Sent Events (SSE) 或 WebSocket Stream 模式。 这种流式传输带来了两个显著的痛点:

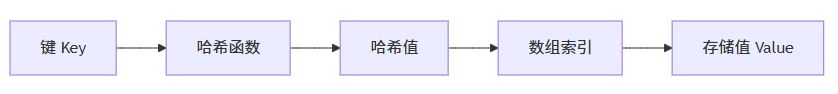

如果无法解决这些问题,用户就会产生一种“失控感”,这对于产品的商业留存是致命的。 二、核心内容讲解:中断机制与状态回滚要实现这两个功能,核心在于理解前端控制流与后端数据流的协同。 1. “停止生成”的实现原理在Web开发中,标准的HTTP请求可以通过AbortController接口来中断。在流式请求中,原理相同,但需要处理流读取器的释放。

2. “重新回答”的逻辑闭环“重新回答”本质上是一次状态回滚。

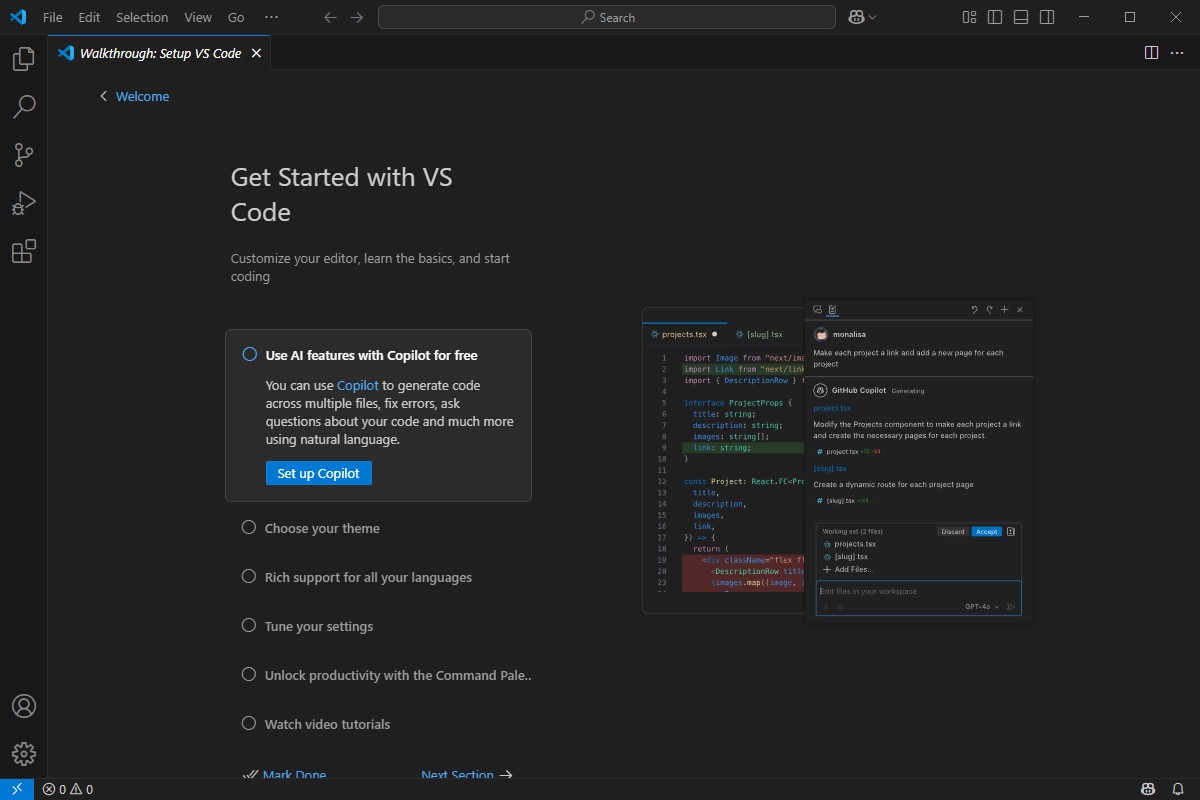

三、实战代码与案例为了更清晰地演示,我们以前端 TypeScript (React技术栈) 和后端 Python (FastAPI) 为例,构建一个最小可行性案例。 1. 前端实现:停止与重试逻辑这是核心的交互逻辑层。我们需要维护一个messages列表和一个abortController实例。

2. 后端视角:FastAPI的中断检测后端不仅仅是被动接收,最好能感知前端断开,以停止GPU计算。FastAPI中可以通过检查request.is_disconnected()来实现。

代码解析: 四、总结与思考在AI应用开发中,我们往往沉迷于Prompt的调优和RAG架构的设计,却忽视了交互层面的工程细节。实现“停止”与“重试”看似是前端的小功能,实则是对Web应用状态管理能力的考验。 从商业价值角度看,这两个功能直接关联成本与体验: 对于正在转型AI开发的工程师来说,这给我们一个启示:LLM应用不仅仅是算法的堆叠,更是传统Web工程能力在流式数据场景下的延伸与重构。只有将扎实的工程底座与AI能力结合,才能构建出真正具备商业竞争力的产品。 |

您可能感兴趣的文章 :

- Python语言在AI中的常用工具和应用场景

- Python从零开始训练AI模型的教程

- PyCharm接入DeepSeek实现AI编程的操作流程

- Python langchain ReAct使用范例介绍

- 解决遇到:PytorchStreamReader failed reading zip archive:failed f

- python项目导入open3d后报错ImportError:DLL load failed:找不到指定的模块问题

- python-redis-lock实现锁自动续期的源码逻辑

- 解决python pip安装第三方模块报错:error:legacy-install-failure

- python使用openai生成图像的教程

- pip安装python库时报Failed building wheel for xxx错误的解决方法

-

Python使用VSCode+Anaconda+DeepSeek开发软件并打包为e

本文面向Python新手,全程实操无冗余理论,基于VSCode+Anaconda Prompt环境,完成从DeepSeek辅助生成Python代码、调试运行,到最终打包为可双击运 -

vscode+anaconda搭建python虚拟环境全攻略

在当今数字化时代,Python 作为一种功能强大且易于学习的编程语言,被广泛应用于数据科学、人工智能、Web 开发等众多领域。为了顺利开启 -

AI对话中的“停止生成”与“重新回答”交互逻辑

在当前的AI应用开发浪潮中,很多从传统Web转型AI的开发者(包括曾经的我)容易陷入一个误区:认为只要调通了LLM的API,把文本渲染到页面 -

Python利用正则提取字符串中数字的方法

方法1:最简单直接的方法(推荐) 1 2 3 4 5 6 7 8 9 10 11 12 import re text = cn_000858 # 提取所有数字 numbers = re.findall(r\d+, text) print(numbers) # [000858] -

python实现PDF文档提取,分割与合并操作

一、PDF提取文字/转图片 提取文字和转图片使用的是fitz模块,模块安装: 1 pip install PyMuPDF 提取文字 1 2 3 4 5 6 7 8 9 10 11 12 13 import fitz pdf = f -

Python中enumerate函数的巧妙用法

在算法题目中,处理数组(List)、字符串、矩阵等可迭代对象时,同时获取索引和元素值 是高频需求 比如找目标元素的位置、双指针遍历 -

Python中的断言机制的介绍

想象你正在开发一个电商系统,有个计算商品折扣的函数。正常情况下,折扣率应该在0到1之间,但某天测试时发现某个商品折扣变成了1. -

Python使用MySQL数据库进行事务处理示例

一、事务核心概念(先理解再实操) 事务(Transaction)是数据库操作的最小逻辑单元,遵循ACID 原则: 原子性(Atomicity):要么全部执行成 -

Python多进程与多线程适用场景案例

你想明确多进程和多线程各自的适用场景,核心是要结合任务类型、资源需求、数据共享等维度来判断简单来说,IO密集型任务优先用多线程

-

python批量下载抖音视频

2019-06-18

-

利用Pyecharts可视化微信好友的方法

2019-07-04

-

python爬取豆瓣电影TOP250数据

2021-05-23

-

基于tensorflow权重文件的解读

2021-05-27

-

解决Python字典查找报Keyerror的问题

2021-05-27