pytorch中torch.cat和torch.stack的区别

torch.cat和torch.stack是 PyTorch 中用于组合张量的两个常用函数,它们的核心区别在于输入张量的维度和输出张量的维度变化。以下是详细对比: 1.torch.cat(Concatenate) 作用:沿现有维度拼接多个张量

|

torch.cat 和 torch.stack 是 PyTorch 中用于组合张量的两个常用函数,它们的核心区别在于输入张量的维度和输出张量的维度变化。以下是详细对比: 1.torch.cat (Concatenate)作用:沿现有维度拼接多个张量,不创建新维度 输入要求:所有张量的形状必须除拼接维度外完全相同。 语法:

示例:

特点:

2. torch.stack作用:沿新维度堆叠多个张量,创建新维度。 输入要求:所有张量的形状必须完全相同。 语法:

示例:

特点:

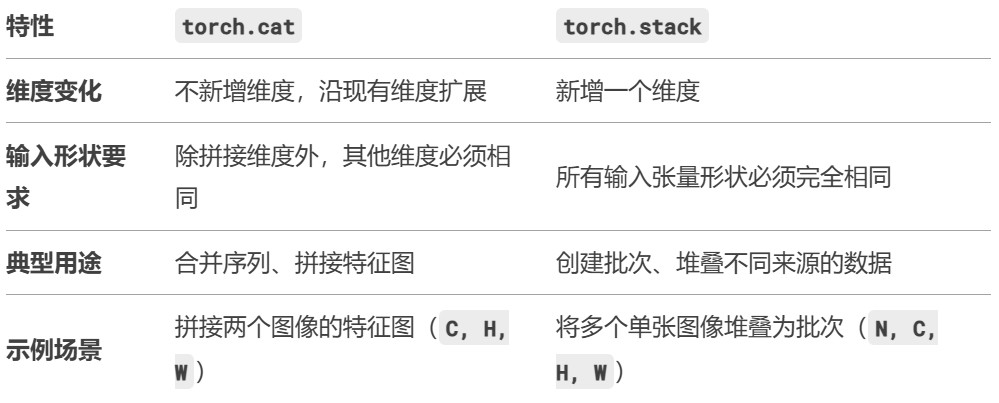

3. 关键区别总结

4. 直观对比示例假设有两个张量:

torch.cat 结果:

torch.stack 结果:

5. 如何选择?

通过理解两者的维度变化逻辑,可以避免常见的形状错误(如 size mismatch)。 |

您可能感兴趣的文章 :

-

pytorch中torch.cat和torch.stack的区别

torch.cat和torch.stack是 PyTorch 中用于组合张量的两个常用函数,它们的核心区别在于输入张量的维度和输出张量的维度变化。以下是详细对比: -

Python实现快速扫描目标主机的开放端口和服务

功能介绍 这是一个功能强大的端口扫描器脚本,能够快速扫描目标主机的开放端口和服务。该脚本具备以下核心功能: 多种扫描模式:支持 -

Python轻松实现Word到Markdown的转换

在文档管理、内容发布等场景中,将 Word(.doc/.docx)转换为 Markdown 格式是常见需求。Markdown 的轻量、跨平台、易编辑特性,使其更适配网页 -

python可变/不可变对象及+=和=+举例

在Python开发中,可变对象与不可变对象是一个高频基础概念,也是初学者容易混淆的难点。这两类对象的核心差异不仅影响变量赋值、函数 -

Python使用Spire.XLS for Python实现高效读取Excel数据

在当今数据驱动的世界中,Python 已成为数据处理和分析的首选工具。而 Excel 文件作为最常见的数据存储格式之一,如何高效、准确地在 P -

Python实现PDF文档高效转换为HTML文件

一、为什么需要PDF转HTML 在数字化办公场景中,PDF因其格式固定、跨平台兼容性强成为文档分发的主流格式。但PDF的静态特性限制了内容复用 -

利用Playwright实现文件上传与下载的完成判断

在自动化测试或网页数据交互场景中,文件上传与下载是极为常见的操作。Playwright 作为强大的自动化测试工具,不仅能模拟用户触发上传和 -

python学习必备知识

一、变量 1.变量 指在程序执行过程中,可变的量; 定义一个变量,就会伴随有3个特征,分别是内存ID、数据类型和变量值。 其他语言运行

-

python批量下载抖音视频

2019-06-18

-

利用Pyecharts可视化微信好友的方法

2019-07-04

-

python爬取豆瓣电影TOP250数据

2021-05-23

-

基于tensorflow权重文件的解读

2021-05-27

-

解决Python字典查找报Keyerror的问题

2021-05-27